数据备份

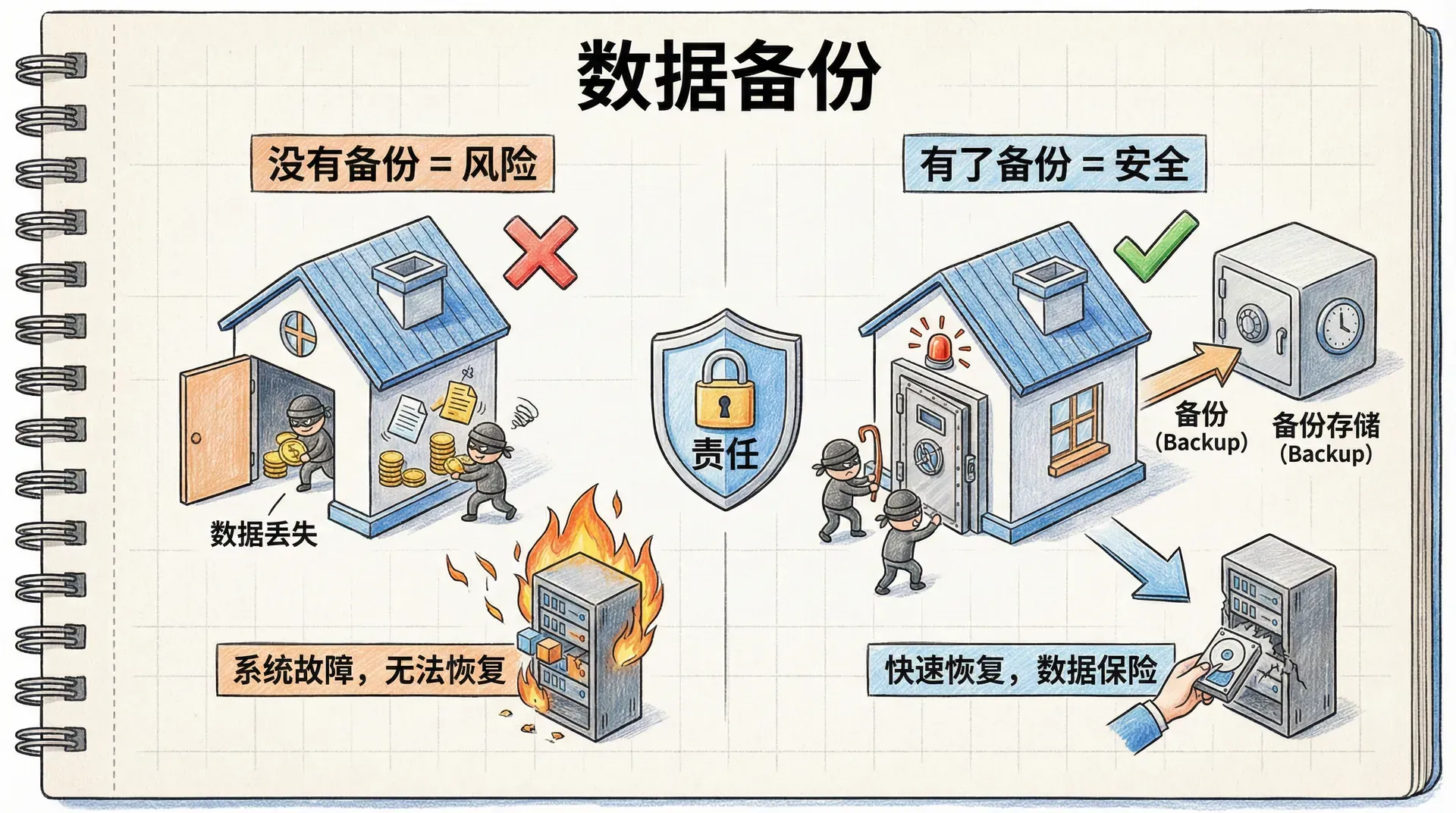

很多初学者在学习数据库时,往往只关注如何高效地存储和查询数据,却忽视了数据安全的重要性。这就像是建造了一座漂亮的房子,却没有安装防盗门和报警系统。 在数据库系统中,数据就是我们的核心资产。无论是电商网站的订单信息、金融系统的交易记录,还是社交平台的用户数据,一旦丢失,后果都非常严重。

数据库备份就像是给我们的数据买了一份保险。当系统遇到故障、硬件损坏或者人为误操作时,一个可靠的备份能帮助我们快速恢复到正常状态。备份不仅仅是技术操作,更是对数据安全的负责任的态度。

备份的基本原则

在开始学习具体的备份方法之前,我们需要了解一些备份的基本原则。这些原则能帮助我们建立正确的备份观念,确保备份的有效性:

记住,备份不是一次性的事情,而是一个持续的过程。我们需要像维护数据库性能一样,定期检查和更新备份策略。

现在我们已经了解了备份的基本概念和重要性,接下来让我们一起探索MongoDB提供的各种备份方法。这些方法从简单的手动备份到自动化的云服务,满足不同场景的需求。

MongoDB的备份工具

MongoDB 作为一款成熟的数据库系统,针对不同业务需求,提供了多样化的备份解决方案。无论是完全托管的云服务,还是自主管理的备份工具,都有各自的应用场景和优势。

云原生备份服务

对于希望简化运维、无需自行管理底层架构的用户来说,MongoDB 官方云平台 Atlas 是理想选择。Atlas 提供企业级的备份能力,包括连续备份和定时快照。

连续备份功能会实时捕捉数据库的变化,确保备份数据几乎与实际数据保持同步(通常延迟仅几秒)。这对于数据变动频繁、对一致性和恢复时效要求高的应用场景(如在线交易、金融系统等)尤为关键。 例如,电商网站在大促期间订单数据剧烈变化,借助 Atlas 的连续备份,即使突发故障,也能恢复到最近的状态,最大程度保障业务连续性和数据安全性。

此外,Atlas 还集成了主流云厂商的原生快照技术。通过利用云服务商的底层能力,企业能够便捷、高效地实现大规模数据的备份与恢复,满足合规和高可用性的专业需求。

自托管备份工具

对于有严格数据管控和自主运维需求的企业用户,MongoDB 也提供了完善的自托管备份工具,比如 Cloud Manager 和 Ops Manager。

Cloud Manager 是 MongoDB 提供的托管型备份与监控服务。而 Ops Manager 则支持在本地数据中心私有化部署。两者都可实现自动备份、监控及集群管理,帮助企业高效运行大规模 MongoDB 环境。

以金融行业为例,银行等机构常因合规、安全等要求,将数据部署和管理在自有基础设施内。通过 Ops Manager,可以在本地建立完善的数据备份与灾备体系,既满足政策要求,又获得与云端等同的专业运维体验。

在选择备份方案时,应综合评估数据价值、项目预算、团队运维能力以及对数据主控权的诉求。对于初学者或希望专注业务开发的团队,推荐优先考虑 Atlas 云托管服务,其自动化备份能力能大大降低管理成本。

除了上述专业平台,MongoDB 还支持通过命令行工具和文件操作等更底层、更灵活的备份手段。接下来我们将系统讲解这些方法及其适用场景。

单机环境备份

单服务器环境依然是许多开发、测试或小型生产系统最常见的部署方式。无论是在本地电脑还是专用服务器,MongoDB 都支持高效的本地备份策略。 在具体实践之前,需要我们注意的是:无论采用哪种方式,备份过程都会消耗一定资源,且会对当前系统性能产生影响。

举例来说,当执行 MongoDB 备份时,系统需要扫描并读取全部数据。就像整理一排装满书的书架,每本书都要取下来、检查归档,自然会对书架(服务器)产生压力、影响正常使用。因此强烈建议在业务访问低峰(如凌晨)执行备份,规避高负载时段。

如果数据库部署为副本集架构,则可进一步优化:主节点专注处理业务写入,从节点负责数据同步和备份任务。在备份时优先选择从节点,可有效减少对线上服务的影响。

备份方法

MongoDB提供了几种不同的备份策略,每种都有其特点和适用场景。我们可以根据自己的需求和技术水平来选择合适的方法。 接下来我们将学习三种主要的备份方法:文件系统快照、复制数据文件,以及使用mongodump工具。这些方法从底层到高层,满足不同用户的需求。

记住,选择备份方法时需要考虑的因素包括:系统负载、数据量大小、恢复时间要求,以及运维团队的技术能力。最好的备份方案是能够持续执行且容易恢复的方案。

文件系统快照备份

文件系统快照是一种高效且专业的备份方案,依托操作系统层面的机制,可以快速生成完整的数据拷贝。特别适用于对备份速度和恢复效率有较高要求的业务场景。

快照原理

文件系统快照本质上是在某一时刻冻结整个文件系统的状态,形成一个只读、一致性的副本。其核心技术通常是写时复制(Copy-on-Write)。当快照创建后,原始数据如发生更改,文件系统会先将旧数据保存到快照区域,再写入新数据。 这样,快照始终呈现出数据在快照产生瞬间的完整视图,而不会占用额外的全部存储空间,仅记录实际发生变化的部分。

对于MongoDB这类数据量较大的数据库系统,文件系统快照能够在几乎不中断服务的情况下,极为迅速地生成备份副本,对数据库的性能影响也非常有限,是企业级环境中常用的冷备工具。

LVM快照在Linux环境中的应用

在Linux系统中,逻辑卷管理器(LVM)为存储管理提供了极大的灵活性,同时也是实现快照功能的主流技术方案。

以MongoDB的数据盘为例,假设已将其配置为LVM逻辑卷。LVM支持动态调整逻辑卷大小,并可以快捷创建快照。创建快照时,需指定一个合理的快照空间(例如100MB),该空间并不等同于数据库的整体容量,而只是用于存储快照期间发生变更的那部分数据。

举例来说,假如MongoDB实例当前数据量为10GB,创建LVM快照时,并不会实际复制全部10GB数据,而是建立一个对应于现有数据状态的引用指针。只有当备份窗口内有数据写入,才会消耗部分快照空间。通常,数据库在备份期间数据写入量有限,因此合理设置快照空间即可满足绝大多数生产需求。

快照空间大小应根据实际业务写入速率和备份窗口期待时长来规划。数据变更频繁时,应预留更宽裕的空间,以防快照溢出。

LVM快照的创建与恢复

下面以Linux环境下的实操为例,演示如何使用LVM快照实现MongoDB数据的备份及恢复。假设现有的MongoDB数据文件存储在单独的LVM逻辑卷上。 首先,我们进行LVM快照的创建。命令如下:

|lvcreate --size 100M --snapshot --name mdb-snap01 /dev/vg0/mongodb

这个命令做了什么呢?它在vg0卷组中的mongodb逻辑卷上创建了一个名为mdb-snap01的快照,大小限制为100MB。路径/dev/vg0/mongodb指向我们的MongoDB数据卷,而/dev/vg0/mdb-snap01将是新创建的快照。

快照创建后,我们就可以挂载它并复制数据了:

|umount /dev/vg0/mdb-snap01 dd if=/dev/vg0/mdb-snap01 | gzip > mdb-snap01.gz

先通过第一条命令确保快照没有被挂载,接着用dd做块级复制,同时用gzip一边压缩。这一步做出来的压缩文件就是我们的备份,可以拿去安全存放。

为什么压缩呢?因为快照本身通常会比较大,压缩后能省不少空间,也方便后续的存储和传输。就像打包行李,把衣服都塞进箱子再压缩,搬起来会更省事。

从快照恢复数据

当需要恢复时,我们先创建一个新的逻辑卷来存放恢复的数据:

|lvcreate --size 1G --name mdb-new vg0 gzip -d -c mdb-snap01.gz | dd of=/dev/vg0/mdb-new mount /dev/vg0/mdb-new /srv/mongodb

上述步骤依次完成了新逻辑卷的创建、备份文件的解压与恢复,并将其挂载至MongoDB的数据目录,整个过程高效且具备可操作性。

恢复后,需要关注mongod.lock文件。该文件通常在MongoDB未正常关闭时存在,若直接保留,可能导致MongoDB判断为异常关机而拒绝启动。 一般情况下,如果数据库启用了日志并且未使用db.fsyncLock(),可以保留该锁文件;但若在备份前启用了fsyncLock(),恢复时应手动删除mongod.lock,以确保MongoDB能够正常启动。

恢复备份时一定要确保MongoDB没有运行,并且目标数据目录是空的。这样可以避免数据混乱或损坏。

远程备份的技巧

在现代的分布式环境中,我们通常需要将备份存储到远程服务器上。LVM快照配合SSH可以轻松实现这个需求:

|umount /dev/vg0/mdb-snap01 dd if=/dev/vg0/mdb-snap01 | ssh username@example.com gzip > /opt/backup/mdb-snap01.gz

这个命令序列通过SSH将压缩的快照直接传输到远程服务器,避免了本地存储的中间步骤。 恢复时也类似:

|lvcreate --size 1G --name mdb-new vg0 ssh username@example.com gzip -d -c /opt/backup/mdb-snap01.gz | dd of=/dev/vg0/mdb-new mount /dev/vg0/mdb-new /srv/mongodb

这种方式特别适合有专用备份服务器的环境,既保证了数据的安全性,又提高了备份的效率。 文件系统快照是一种强大的备份方法,特别适合对性能要求较高的生产环境。但它需要一定的系统配置知识,对于初学者来说可能有一定的学习曲线。

复制数据文件进行备份

除了采用文件系统快照外,还可以使用一种更为直接的备份方式:直接复制MongoDB的数据文件。可以将这种方法理解为为数据库“定格”当前的状态,前提是在确保数据静止、不变更的情况下进行复制。

fsyncLock 的原理与作用

此方法关键在于保证备份期间数据文件内容不会发生变化。实现这一目标,最常用也是推荐的手段是利用 fsyncLock 命令。

打个比方,fsyncLock 就像图书馆管理员在盘点期间临时暂停所有借还操作。所有借书、还书的请求都被暂时挂起,管理员完成盘点后再恢复办理业务。MongoDB 的 fsyncLock 命令正是通过阻止所有写入,把所有内存中的写操作同步刷新到磁盘,确保磁盘中的数据一致且完整。

我们可以在 mongo shell 中执行如下命令完成锁定和刷盘操作:

|> db.fsyncLock()

执行后,mongod会暂停所有写入操作,将队列中的写入请求暂时挂起。数据库进入只读状态,这时,你就可以安全地复制数据文件了:

|$ cp -R /data/db/* /mnt/external-drive/backup

复制完成后,别忘了解锁数据库:

|> db.fsyncUnlock()

然后,数据库会恢复正常写入功能,所有排队的写入操作也会继续执行。

使用fsyncLock时有一个重要的注意事项:如果你启用了认证,在锁定和解锁之间不要断开shell连接。如果断开,你可能无法重新连接,需要重启mongod才能解锁。

停机备份

在某些场景下,如果不便于使用 fsyncLock,最直接且可靠的方式是停机备份,即完全关闭 MongoDB 服务进行数据文件复制。 停机备份的标准流程如下:

- 正常关闭 mongod 实例,确保所有数据安全写入磁盘

- 将数据文件完整复制到备份位置,确保无遗漏

- 重新启动 mongod 服务

关闭 Mongod 进程后,所有内存中的写入数据都会被同步到磁盘,从而保证数据的一致性。重新启动数据库时,MongoDB 会自动校验数据文件的完整性,确保服务平稳恢复。

停机备份适用于数据量较小的系统、维护窗口期或业务流量低谷时。在生产环境中,建议合理安排备份时间,以最大程度降低对业务的影响。

恢复数据文件备份

从数据文件备份恢复数据也非常简单:

- 确保mongod没有运行

- 清空目标数据目录

- 复制备份文件到数据目录

- 启动mongod

|$ cp -R /mnt/external-drive/backup/* /data/db/ $ mongod -f mongod.conf

MongoDB启动时会自动检查数据文件的完整性,如果发现日志文件会自动重放,确保数据的一致性。

部分数据库备份

在某些情况下,你可能只需要备份特定的数据库。这在MongoDB中使用--directoryperdb选项时特别有用。 假设你的MongoDB启用了--directoryperdb,每个数据库都有自己的目录。这时你可以只复制特定数据库的目录:

|$ cp -R /data/db/myApp /mnt/backup/

恢复时也只需要复制对应的目录到数据文件夹中。 但需要注意:这种部分备份只能在干净关机的情况下进行。如果发生了崩溃或意外关机,不要尝试部分恢复,应该恢复整个数据目录,让MongoDB的日志系统来保证数据一致性。

永远不要在发生崩溃后尝试部分恢复数据库。这可能会导致数据不一致或丢失。正确的做法是恢复完整的数据目录,让MongoDB的日志重放机制来处理数据恢复。

复制数据文件的方法简单直接,特别适合小型数据库或需要完整数据拷贝的场景。但它需要停止写入操作,在高并发环境中很可能影响用户体验。

使用mongodump进行备份

mongodump是MongoDB官方提供的备份工具,它通过网络连接到MongoDB服务器,将数据导出为BSON格式的文件。这种方法就像是给数据库拍X光片,能够精确地记录数据的状态。

mongodump的基本用法

最简单的备份命令只需要指定MongoDB运行的端口:

|$ mongodump -p 31000

这个命令会在当前目录创建一个dump文件夹,里面按照数据库和集合的层次结构组织备份文件。每个集合的数据都以.bson格式存储,这些文件包含了集合中所有文档的完整BSON数据。 你也可以直接指定数据目录进行备份,而不需要服务器运行:

|$ mongodump --dbpath /data/db

这种方法非常适合离线场景,或是基于已有的数据目录进行备份时使用。

mongodump的优势

尽管本节最后才介绍mongodump,但它在灵活性方面具有其他备份方式难以比拟的优势。 mongodump 支持针对特定数据库、集合,甚至集合中的部分数据进行备份。例如,仅备份 users 数据库:

|$ mongodump -p 31000 -d users

或者只备份某个特定的集合:

|$ mongodump -p 31000 -d myapp -c products

此外,它支持查询条件,可以只备份符合特定条件的文档:

|$ mongodump -p 31000 -d myapp -c orders -q '{"status": "completed"}'

这种灵活性让mongodump成为数据迁移和部分备份的理想工具。

需要注意的是,mongodump 并不能实现真正的原子快照备份。在备份执行的过程中,数据库依然可能会有新的写入操作。举例来说,这就像你试图为一幅正在被持续修改的画作拍照——如果绘画过程没有暂停,相片捕捉到的就只是某个时间流动中的状态,难以反映出某一具体时刻的全部情况。

因此,单纯使用 mongodump 进行备份时,可能会导致获取到的数据处于不一致状态。例如,在备份过程中,用户可能完成了一个订单,但对应的库存信息尚未更新,这种“中间态”的数据会进入备份文件。

为了解决这一一致性的问题,如果你的 MongoDB 实例处于副本集模式,强烈推荐在备份时配合使用 --oplog 参数:

|$ mongodump -p 31000 --oplog

这个选项会记录备份过程中发生的所有操作,确保恢复时能够重放到一个一致的时间点。

从备份恢复数据

数据恢复可通过专业的 mongorestore 工具完成:

|$ mongorestore -p 31000 --oplogReplay dump/

如果使用了--oplog选项备份,就必须使用--oplogReplay选项恢复。 在恢复到运行中的服务器时,你可能需要使用--drop选项来先删除现有集合:

|$ mongorestore -p 31000 --drop --oplogReplay dump/

使用相同版本的mongodump和mongorestore可以避免兼容性问题。MongoDB的版本更新时,备份格式可能发生变化。

数据迁移

mongodump 与 mongorestore 在数据迁移场景下尤为强大。结合 SSH 及压缩功能,可以高效且安全地在多台服务器间传输数据:

|$ mongodump --host source.server.com --archive --gzip | ssh user@target.server.com mongorestore --archive --gzip

这个命令序列实现了从源服务器到目标服务器的无缝数据迁移,整个过程不需要中间存储。 mongodump虽然不是最快的备份方法,但它的灵活性和网络备份能力使其成为MongoDB备份工具箱中不可或缺的一部分。特别是在需要精确控制备份内容或进行数据迁移时,mongodump是最佳选择。

从MongoDB 4.2开始,不建议使用mongodump/mongorestore作为分片集群的备份策略,因为它们不能保证跨分片事务的原子性。对于分片集群,应该使用文件系统快照或其他专门的集群备份方法。

副本集备份

当 MongoDB 以副本集方式部署时,备份策略会比单机环境更加复杂。原因在于,除了需要保障业务数据的完整,还必须保存副本集的配置信息和成员关系,以便在发生故障或迁移时能够顺利重建和恢复整个副本集架构。

副本集不仅包含所有业务数据,还承担节点角色分工(主节点负责写入,从节点负责同步和读请求)、成员选举与同步状态等元数据。这些内容类似于一个公司内部既有各类业务信息,也有详细的组织架构和岗位职责。 备份时,需要同时记录这两部分,才能确保灾备恢复后,集群能正常运行并维持原有的功能与角色分配。

选择从节点备份的优势

在副本集环境中,生产实践中建议优先在从节点(secondary)上完成备份操作。这样可以充分减轻主节点的数据写入压力,避免在生产高峰期因备份导致主节点性能下降。备份本身通常涉及高 IO、CPU 负载,将其放到从节点可以显著提升业务的可用性和稳定性。

尤其推荐选择隐藏节点(hidden member)来承担备份任务。隐藏节点不会响应普通读写请求,也不参与主节点选举,专职用于备份和管理等后台维护,有助于保障业务连续性。

副本集推荐的备份方式

针对副本集成员,可以参考前面我们介绍的单节点常用备份方法,但其实我们更加推荐使用文件系统快照或数据文件复制实现高效、安全的备份操作。

在从节点上创建 LVM 快照的步骤,与单机环境基本一致:

|# 在从节点上执行 lvcreate --size 100M --snapshot --name backup-snap01 /dev/vg0/mongodb umount /dev/vg0/backup-snap01 dd if=/dev/vg0/backup-snap01 | gzip > replica-backup.gz

这个备份包含了从节点的完整数据和副本集状态。

使用数据文件复制

除了文件系统快照外,我们也可以在从节点上使用fsyncLock进行备份:

|# 连接到从节点 > db.fsyncLock() # 在另一个终端复制文件 $ cp -R /data/db/* /backup/location/ > db.fsyncUnlock()

恢复时,将备份文件复制到新的服务器,然后将其作为副本集成员启动即可。

mongodump在副本集中的应用

虽然mongodump不如文件系统快照高效,但在副本集中使用时有一些特殊的考虑。 关键是要使用--oplog选项获取时间点一致性:

|$ mongodump --host replica-set-seed --oplog

这个命令会连接到副本集(通过种子节点),自动选择主节点进行备份,并记录备份期间的所有操作。 恢复副本集成员需要更多步骤:

- 将目标服务器作为独立服务器启动(不加入副本集)

- 运行mongorestore恢复数据

- 创建oplog集合

- 恢复oplog数据

- 重新配置为副本集成员

具体操作:

|# 1. 作为独立服务器启动 $ mongod --dbpath /data/db --logpath /var/log/mongodb.log --fork # 2. 恢复数据 $ mongorestore --oplogReplay dump/ # 3. 创建oplog集合 > use local > db.createCollection("oplog.rs", {"capped": true, "size": 10000000}) # 4. 恢复oplog $ mongorestore -d local -c oplog.rs dump/oplog.bson # 5. 重新启动并加入副本集

上述过程确保了恢复的成员拥有正确的oplog,能够与其他成员同步。

oplog的大小应该根据你的工作负载来设置。通常建议设置为可用磁盘空间的5-10%。上面的例子使用了10MB作为示例。

副本集备份的核心原则是平衡数据一致性和系统性能。通过选择合适的从节点和备份方法,我们能够在保证业务连续性的同时获得可靠的备份。

分片集群备份

分片集群是 MongoDB 针对大规模数据处理而设计的核心架构,其备份机制与单机或副本集模式相比,存在本质上的区别。可以把分片集群类比为一个复杂的物流系统——数据被分布存储在多个分片(即“仓库”)中,而备份这样一个体系则需要采用更具针对性的专业策略。 为什么分片集群的备份尤其具有挑战性?核心在于分片环境下数据始终处于动态迁移中。

想象你要对一个持续运转的物流中心整体拍照留档,但此时货物正被频繁地从一个仓库转运到另一个仓库。即使你协调同时拍照,依然难以确保每个快照反映的是完全一致的全局状态。 对于 MongoDB 分片集群而言,balancer(均衡器)组件负责动态地在各分片之间平衡 chunk(数据块),以优化负载。当你在备份其中一个分片时,其他分片上的数据块可能正在被迁移。

因此,备份操作无法做到对全集群某一绝对瞬时状态的精确捕获,这种“时间窗口差”是分片集群备份中的一个客观存在的问题。

备份策略的发展思路

随着分片集群规模扩大,全面覆盖整个集群的备份反倒不再是绝对主流。

这是因为,分片集群强调高可用架构设计:即便单个分片发生故障,集群的整体服务依然可以继续提供,通常只需要针对发生故障的分片进行恢复即可。因此,实际运维中分片集群的备份策略更侧重于“部分备份”——即对配置服务器与各数据分片分别备份——而非一味追求单时间点的全量快照。

均衡器管理要点

在进行任何分片集群的备份前,务必先确保均衡器(balancer)已处于关闭状态。均衡器相当于物流中心的调度指挥,如果它在备份过程中仍在安排数据迁移,那么备份数据的一致性与有效性将难以保证。

关闭均衡器的方法:

|// 连接到mongos > use config > db.settings.updateOne({_id: "balancer"}, {$set: {stopped: true}}, {upsert: true})

确认均衡器已停止:

|> db.settings.findOne({_id: "balancer"})

恢复均衡器:

|> db.settings.updateOne({_id: "balancer"}, {$set: {stopped: false}})

在备份过程中保持均衡器关闭。在备份完成后,务必重新启用均衡器,否则新的数据分布会不均衡。

备份整个集群

虽然完整集群备份变得不那么重要,但在某些情况下(如小型集群或开发环境),我们仍然需要备份整个集群。

我们可以使用的方法是关闭均衡器,然后通过mongos运行mongodump:

|$ mongodump --host mongos-host:port --out /backup/cluster-backup

这个命令会通过mongos连接到所有分片,创建包含完整集群数据的备份。

恢复时也通过mongos进行:

|$ mongorestore --host mongos-host:port /backup/cluster-backup

但这种方法会有我们提到的时间差的问题:不同分片的备份完成时间不同,在这个时间窗口内发生的数据迁移不会被正确记录。

备份单个分片

在实际的生产环境中,单独备份某个分片往往比全量集群备份更为常见。当某个分片出现故障时,可以通过恢复该分片的备份以实现快速修复,提升整体可用性。 由于每个分片通常本身就是一个副本集,因此可直接沿用前述副本集的备份与恢复方案,这既规范又高效。

但在操作过程中,需要特别注意备份时序带来的数据一致性问题。比如:假设你在周一完成了对分片A的备份,到了周四分片A故障并计划进行恢复。在这三天内,均衡器有可能将其他分片的数据块迁移至分片A。这些在周一之后迁移过来的数据块,并不包含在周一的备份中。

所以,如果直接用周一的备份进行恢复,分片A在发生切换或故障恢复后,会缺失这期间被均衡器分配的新数据块,造成数据的不完整。

直接从分片备份恢复可能会丢失迁移到该分片的新数据块。在恢复前,务必检查配置服务器,确认哪些数据块应该属于这个分片。

在大多数情况下,我们接受这种数据丢失的风险,因为:

- 丢失的数据通常可以从其他副本或应用层重新获取

- 相比完全恢复整个集群,单分片恢复要快得多

- 大规模集群的设计目标之一就是容忍部分数据丢失

与其追求完美的完整性,不如确保快速恢复和业务连续性。对于超大规模的系统,我们甚至在有些情况下可能选择不备份某些分片,而是依赖数据的多副本和自动故障转移。

到这里,我相信你已经掌握了足够多关于MongoDB数据库的知识来搭建你的应用了。如果你已经迫不及待的动手了,那么你可以考虑使用MongoDB Atlas来搭建你的应用,这对于我们个人学习完全够用了。