网络与分布式系统

分布式系统作为现代计算架构的核心范式,构成了互联网、云计算和大数据处理等关键应用的技术基础。从移动设备访问远程服务到跨地域数据中心的数据同步,这些看似简单的操作背后,都依赖于由多个独立计算节点通过网络互连构成的分布式系统架构。

分布式系统在学术上被定义为由多个自治的计算节点组成的系统,这些节点通过消息传递机制进行通信和协调,共同完成单一系统无法实现的计算任务。每个节点拥有独立的处理单元、本地存储空间和时钟系统,节点之间不共享物理内存,也不依赖全局时钟同步。这种架构设计使得分布式系统能够在物理上分散、异构的环境中运行,同时通过冗余和并行处理提供高可用性和高性能。

互联网(Internet)作为全球规模最大的分布式系统实例,连接了数十亿台异构的计算设备,这些设备运行着不同的操作系统,采用不同的硬件架构,但通过统一的通信协议栈(如TCP/IP协议族)实现了跨平台、跨地域的无缝互联。互联网的分层架构和自治系统(Autonomous System, AS)设计,使得即使部分网络出现故障,整体通信依然能够通过动态路由选择保持连通性,这体现了分布式系统容错性的核心特征。

网络结构

分布式系统的实现依赖于底层网络基础设施,网络拓扑结构和通信机制直接影响系统的性能、可靠性和可扩展性。现代计算机网络采用分层架构设计,从物理层的信号传输到应用层的数据交换,形成了完整的协议栈体系。

局域网和广域网

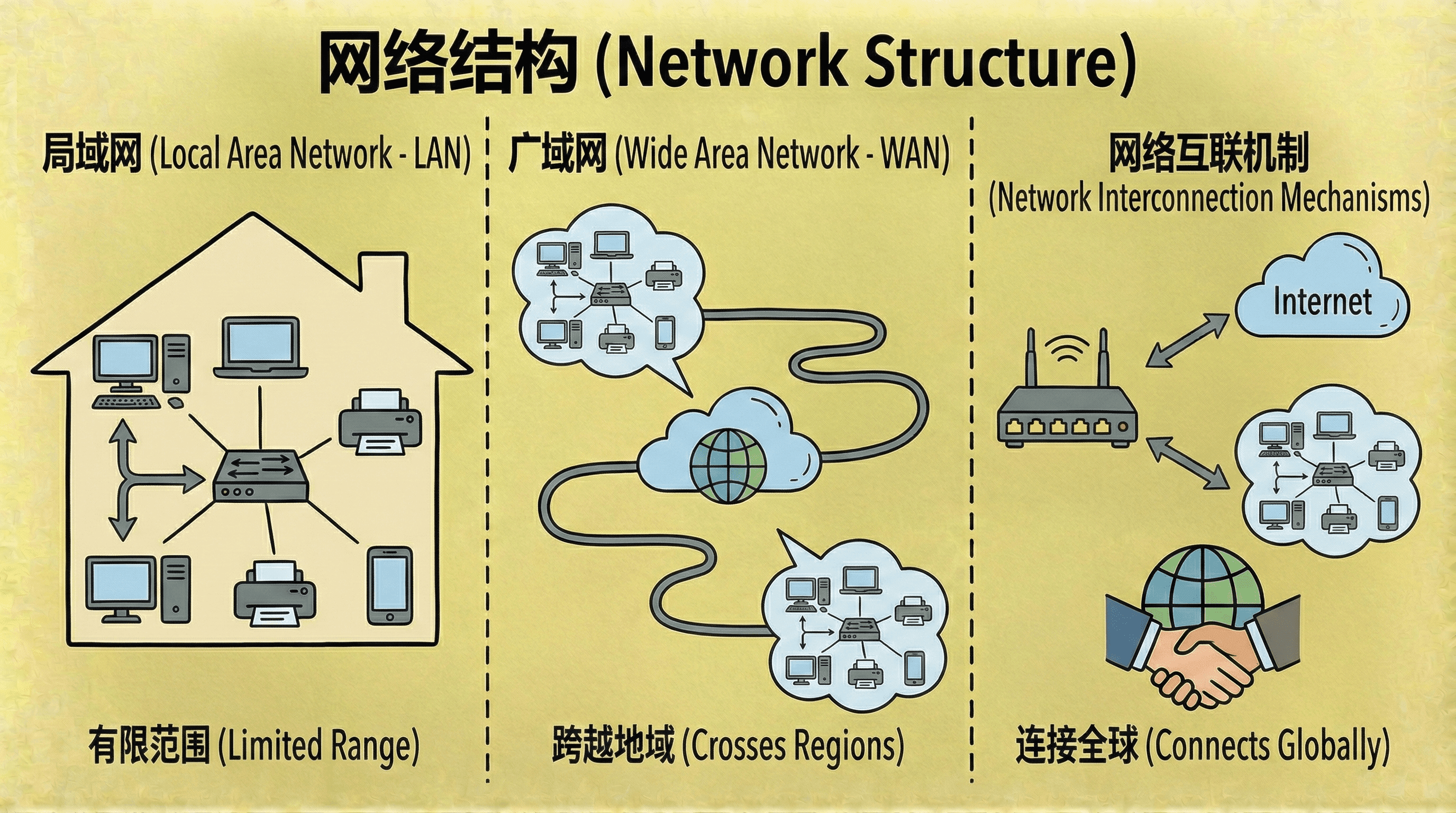

在计算机网络分类体系中,局域网(Local Area Network, LAN)和广域网(Wide Area Network, WAN)代表了两种不同规模和特性的网络类型。局域网通常覆盖有限的地理范围,如单个建筑物或校园环境,其特点是高带宽、低延迟和低误码率,适合高速数据交换和资源共享。广域网则跨越广阔的地理区域,连接不同城市、国家甚至洲际的网络节点,侧重于远距离数据传输和多网络互联,其延迟和带宽特性受物理距离和传输介质影响显著。

这两类网络在物理层实现、数据链路层协议、网络层路由机制以及管理策略等方面存在本质差异。局域网通常采用广播或多点接入的共享介质访问方式,而广域网则依赖点对点链路和分组交换技术。这些差异反映了不同应用场景对网络性能、成本和可管理性的不同需求,是现代分布式系统架构设计的重要考量因素。

局域网

局域网技术起源于1970年代初,当时小型计算机(Minicomputer)的普及使得将多台计算机互连以共享资源比使用大型主机(Mainframe)更加经济高效。局域网覆盖的地理范围通常在几公里以内,典型场景包括单个建筑物或相邻建筑物群,所有网络设备通过高速物理链路连接,通信延迟通常在微秒级,误码率极低。

典型的局域网基础设施包括终端设备(如工作站、服务器、移动设备)、网络互连设备(如交换机、路由器)以及共享外围设备(如网络打印机、网络存储设备)。这些设备通过标准化的物理层和数据链路层协议进行通信,实现资源共享和数据交换。

以太网(Ethernet)和无线局域网(Wireless LAN, WLAN)是构建局域网的两种主流技术。以太网遵循IEEE 802.3标准,采用载波监听多路访问/冲突检测(CSMA/CD)介质访问控制机制,传输速率从早期的10 Mbps发展到当前的10 Gbps,在特定应用场景下甚至可达100 Gbps。无线局域网遵循IEEE 802.11标准族,采用载波监听多路访问/冲突避免(CSMA/CA)机制,传输速率从11 Mbps(802.11b)发展到当前的数Gbps(802.11ax/6E),同时支持多输入多输出(MIMO)技术和正交频分复用(OFDM)调制技术,显著提升了频谱利用率和传输可靠性。

广域网

广域网(Wide Area Network, WAN)是跨越广阔地理区域的分组交换网络,其设计目标是在远距离节点之间实现可靠的数据传输和多网络互联。广域网不仅连接不同城市的网络节点,更能够实现跨省份、跨国家甚至跨洲际的网络互连,是现代信息社会基础设施的核心组成部分。

1960年代末,美国国防部高级研究计划局(Advanced Research Projects Agency, ARPA)资助的ARPANET项目被认为是现代广域网的起源。ARPANET采用分组交换(Packet Switching)技术,突破了传统电路交换(Circuit Switching)的局限,实现了统计复用和动态路由选择,为后续互联网的发展奠定了技术基础。分组交换技术将数据分割为固定或可变长度的数据包,每个数据包携带目标地址信息,网络节点根据路由表独立转发每个数据包,这种设计使得网络资源利用率显著提升,同时增强了网络的容错能力。

广域网的物理层实现方式多样,包括传统的公共交换电话网络(PSTN)拨号连接、专用租用线路(Leased Line)、综合业务数字网(ISDN)、数字用户线路(DSL)、同步数字体系(SDH/SONET)光纤网络、微波链路以及卫星通信等。现代广域网主干主要采用密集波分复用(DWDM)光纤技术,其单根光纤可支持数十甚至上百个波长通道,每个通道可提供10 Gbps至400 Gbps的传输容量,总带宽可达数Tbps。卫星通信则适用于偏远地区或跨洋通信场景,通过地球同步轨道(GEO)或低地球轨道(LEO)卫星实现全球覆盖。

广域网的路由和转发功能主要由路由器(Router)实现,路由器运行路由协议(如OSPF、BGP)动态维护路由表,根据数据包的目标IP地址和当前网络拓扑状态,采用最短路径优先(SPF)或路径向量算法选择最优转发路径。路由器的核心功能包括路由计算、转发表维护、数据包分类和队列调度,其性能直接影响网络的吞吐量和延迟特性。

互联网(Internet)作为全球最大、最复杂的广域网实例,采用分层的自治系统(AS)架构。每个自治系统由一组在统一管理策略下运行的路由器组成,自治系统之间通过边界网关协议(Border Gateway Protocol, BGP)交换路由信息。互联网连接了全球数以亿计的计算设备,这些设备运行着异构的操作系统(如Windows、Linux、macOS、iOS、Android),采用不同的硬件架构(如x86、ARM、RISC-V),但都遵循TCP/IP协议族,实现了跨平台、跨地域的无缝互联。互联网的分层结构和分布式路由设计,使得即使部分网络出现故障,整体通信依然能够通过动态路径选择保持连通性,这体现了分布式系统可靠性的核心特征。

网络互联机制

局域网和广域网在技术实现上存在显著差异,但在实际网络架构中,它们往往通过网关(Gateway)和路由器等互连设备形成层次化的网络体系。这种层次化设计使得不同规模和特性的网络能够无缝集成,共同构成全球互联网基础设施。

移动设备接入互联网的过程体现了这种层次化网络架构。当移动设备通过WiFi或蜂窝网络(如4G/5G)接入时,首先与附近的接入点(Access Point, AP)或基站(Base Station, BS)建立物理层和数据链路层连接,这一阶段类似于局域网的接入过程。数据包离开接入点后,进入运营商的核心网络(Core Network),经过移动性管理实体(MME)、服务网关(SGW)和分组数据网关(PGW)等网络功能节点,最终通过运营商的路由器接入互联网骨干网,此时数据包进入了广域网的传输路径,可能跨越多个自治系统,经过数千公里的物理距离,最终到达目标服务器。

路由器在网络互联中扮演关键角色,它实现了不同网络之间的数据包转发和路由选择。路由器维护路由表(Routing Table),其中记录了到达不同网络前缀的下一跳地址和出接口信息。当数据包到达路由器时,路由器提取数据包的目标IP地址,通过最长前缀匹配(Longest Prefix Match, LPM)算法在路由表中查找匹配项,确定数据包的转发路径。现代路由器还支持多协议标签交换(MPLS)、流量工程(Traffic Engineering)和负载均衡等高级功能,能够根据网络拥塞状况、链路质量和业务优先级动态调整转发策略,实现网络资源的优化利用和服务质量(QoS)保障。

通信结构

网络通信的实现依赖于分层的协议栈架构,每一层提供特定的功能抽象,上层协议利用下层协议提供的服务,最终实现端到端的数据传输。这种分层设计使得不同厂商的设备能够互操作,同时便于协议的独立演进和优化。

命名与地址解析

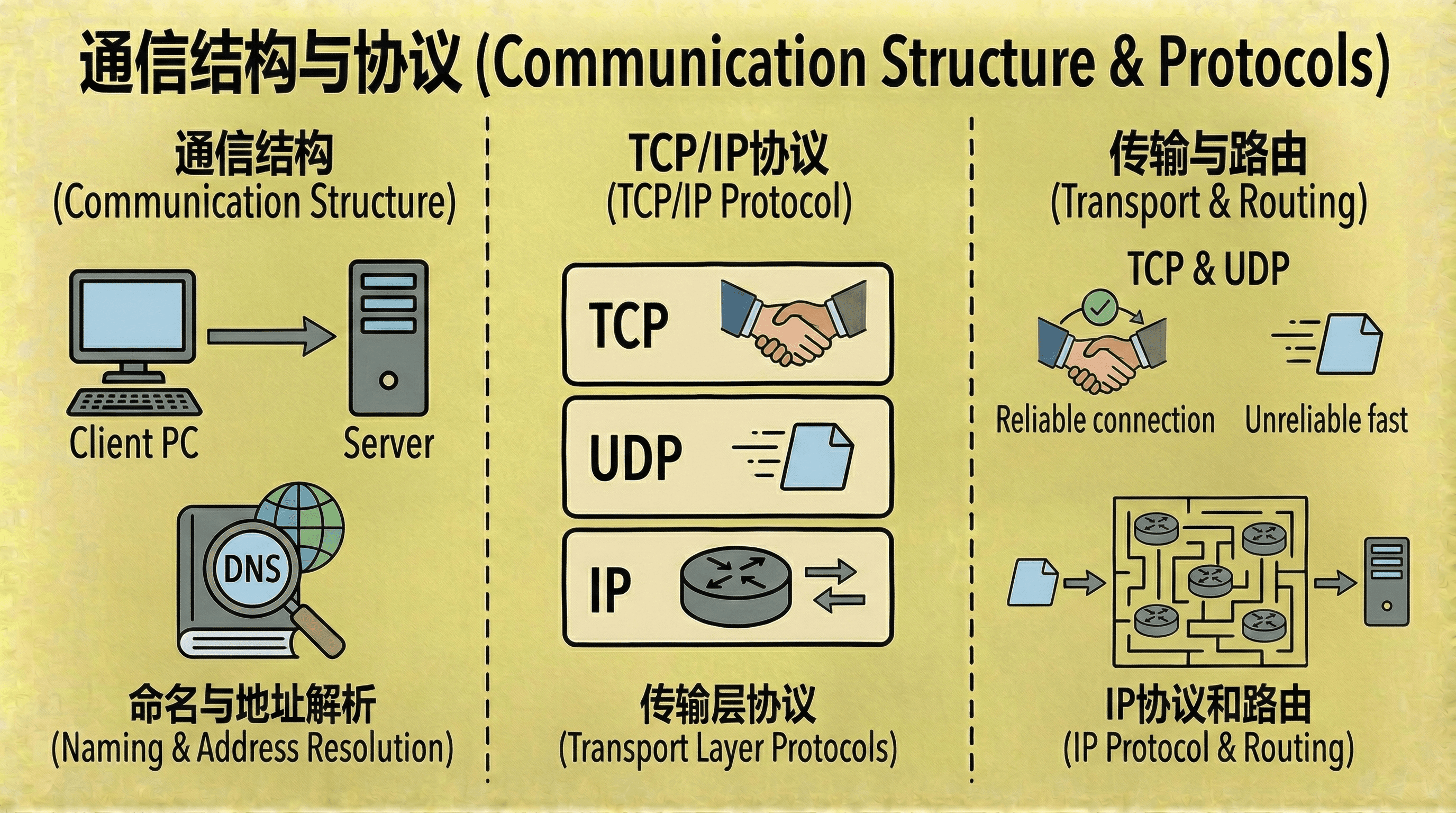

在网络环境中,每个通信实体需要唯一的标识符以便进行寻址和路由。在单机系统中,进程通过进程标识符(Process ID, PID)进行标识,但在分布式环境中,由于节点之间不共享地址空间,需要更复杂的命名和寻址机制。

远程进程通常采用层次化的命名结构,表示为<主机名, 进程标识符>的二元组。主机名是便于人类记忆的符号标识符,如webserver.example.com,而进程标识符则是该主机上的唯一数字编号。这种命名方式将全局的主机标识与局部的进程标识分离,简化了命名空间的管理。

然而,网络层协议(如IP协议)需要数字形式的地址(IP地址)进行路由和转发。IPv4地址采用32位二进制数,通常表示为点分十进制格式(如192.168.1.100),IPv6地址则采用128位二进制数,表示为冒号分隔的十六进制格式。因此,需要一种机制将符号化的主机名映射为数字化的IP地址,这个过程称为域名解析(Name Resolution)。

早期网络采用中心化的主机文件(如Unix系统的/etc/hosts)进行域名解析,所有主机维护相同的映射表副本。随着网络规模扩大,这种方法面临可扩展性和一致性问题。现代互联网采用域名系统(Domain Name System, DNS)进行分布式的域名解析。DNS采用层次化的命名空间,将域名划分为多个标签(Label),从右到左表示从顶级域(Top-Level Domain, TLD)到子域的层次关系。DNS系统由分布在全球的DNS服务器组成,采用递归查询和迭代查询相结合的方式,通过缓存机制减少查询延迟和网络负载。

网络通信协议

网络协议栈采用分层抽象的设计思想,将复杂的通信任务分解为多个相对独立的层次,每一层提供特定的服务接口,隐藏底层实现细节。这种设计既保证了系统的模块化和可维护性,也便于不同厂商和技术的互操作。

国际标准化组织(ISO)提出的开放系统互连参考模型(OSI Reference Model)将网络通信划分为七个层次:物理层(Physical Layer)负责比特流的传输和物理介质的电气特性;数据链路层(Data Link Layer)提供帧的封装、错误检测和介质访问控制;网络层(Network Layer)实现数据包的寻址、路由和转发;传输层(Transport Layer)提供端到端的可靠传输和流量控制;会话层(Session Layer)管理会话的建立、维护和释放;表示层(Presentation Layer)处理数据格式转换和加密解密;应用层(Application Layer)提供用户应用程序的接口。虽然OSI模型在实际部署中并未完全实现,但它为理解网络协议的分工和协作提供了理论框架。

在实际应用中,互联网广泛采用TCP/IP协议族(也称为Internet Protocol Suite),该协议族将OSI模型的七层简化为四层:应用层对应OSI的应用层、表示层和会话层,提供HTTP、FTP、SMTP、DNS等应用协议;传输层对应OSI的传输层,提供TCP(Transmission Control Protocol)和UDP(User Datagram Protocol)两种传输协议;网络层对应OSI的网络层,主要采用IP(Internet Protocol)协议实现数据包的寻址和路由;链路层对应OSI的物理层和数据链路层,处理物理介质的访问和帧的传输。TCP/IP模型以其实用性和高效性成为现代网络通信的事实标准。

随着网络应用的多样化和安全威胁的加剧,现代协议设计越来越重视安全机制。传输层安全协议(TLS)在TCP之上提供加密和认证服务,确保数据的机密性、完整性和通信双方的身份验证。网络层安全协议(IPsec)在IP层提供端到端的安全保障,支持认证头(AH)和封装安全载荷(ESP)两种模式。这些安全机制虽然增加了协议复杂度和处理开销,但在信息安全威胁日益严峻的今天,已成为保障网络通信安全的基本要求。

TCP/IP协议

TCP/IP协议族是互联网的核心协议栈,虽然OSI模型在理论上更加完整,但TCP/IP模型以其简洁性和实用性成为实际部署的主流标准。TCP/IP模型将网络通信抽象为四个层次,每一层通过标准化的协议接口与相邻层交互,实现了跨平台、跨厂商的互操作性。

TCP和UDP:传输层协议

传输层位于网络层和应用层之间,为应用进程提供端到端的数据传输服务。TCP/IP协议族在传输层提供了两种不同的协议:TCP(Transmission Control Protocol)和UDP(User Datagram Protocol),它们分别适用于不同的应用场景和性能需求。

TCP是一种面向连接的、可靠的传输协议,它通过连接建立、数据传输和连接释放三个阶段提供可靠的数据传输服务。TCP的可靠性机制包括序列号(Sequence Number)和确认号(Acknowledgment Number)机制、超时重传(Retransmission Timeout, RTO)机制、流量控制(Flow Control)和拥塞控制(Congestion Control)机制。序列号用于标识每个数据字节的顺序,确认号用于告知发送方已成功接收的数据范围。如果数据包在传输过程中丢失或损坏,发送方会根据未收到的确认信息启动重传机制。流量控制通过滑动窗口(Sliding Window)机制防止发送方发送数据过快导致接收方缓冲区溢出,拥塞控制则通过慢启动(Slow Start)、拥塞避免(Congestion Avoidance)、快速重传(Fast Retransmit)和快速恢复(Fast Recovery)等算法动态调整发送速率,避免网络拥塞。

UDP是一种无连接的、不可靠的传输协议,它不建立连接,直接将数据报发送到目标地址,也不提供确认、重传和流量控制机制。UDP的头部开销小(仅8字节),处理延迟低,适合对实时性要求高、能够容忍部分数据丢失的应用场景,如音视频流媒体、在线游戏、DNS查询等。UDP的不可靠性意味着应用层需要自行处理数据丢失、重复和乱序等问题。

TCP连接建立采用三次握手(Three-Way Handshake)机制:客户端发送SYN(Synchronize)报文,携带初始序列号;服务器响应SYN-ACK报文,确认客户端的序列号并发送自己的初始序列号;客户端发送ACK(Acknowledge)报文确认服务器的序列号。三次握手确保了通信双方都已准备好进行数据传输,并且初始序列号已同步。连接释放采用四次挥手(Four-Way Handshake)机制:主动关闭方发送FIN(Finish)报文;被动关闭方响应ACK报文;被动关闭方发送FIN报文;主动关闭方响应ACK报文。四次挥手确保了所有数据都已传输完成,连接能够安全关闭。

IP协议和路由

网络层采用IP(Internet Protocol)协议实现数据包的寻址和路由功能。IP协议提供无连接、不可靠的数据报传输服务,每个IP数据包独立路由,可能经过不同的路径到达目标地址,也可能出现丢失、重复或乱序的情况。IP协议的可靠性由上层协议(如TCP)保障。

IP地址采用层次化结构,IPv4地址由网络前缀(Network Prefix)和主机标识(Host Identifier)两部分组成,通过子网掩码(Subnet Mask)区分。路由器根据IP地址的网络前缀进行路由决策,将数据包转发到目标网络,目标网络内的最后一跳路由器根据主机标识将数据包交付给目标主机。这种层次化设计显著减少了路由表的规模,提高了路由查找的效率。

在局域网内部,主机需要将IP地址解析为数据链路层的MAC地址才能进行帧的传输。地址解析协议(Address Resolution Protocol, ARP)实现了IP地址到MAC地址的动态映射。当主机需要发送数据包时,它首先检查ARP缓存表,如果找不到对应的MAC地址,则广播ARP请求报文,目标主机响应ARP应答报文,告知其MAC地址。ARP采用缓存机制减少广播请求的频率,提高网络效率。

当数据包需要在不同网络之间传输时,路由器根据路由表(Routing Table)选择转发路径。路由表可能通过静态配置(Static Routing)手动设置,也可能通过动态路由协议(Dynamic Routing Protocol)自动学习和更新。常见的动态路由协议包括距离向量协议(如RIP)、链路状态协议(如OSPF)和路径向量协议(如BGP)。这些协议通过交换路由信息,动态维护网络拓扑视图,计算最优路径,适应网络拓扑变化和链路故障。

分布式系统

分布式系统的架构设计直接影响系统的性能、可扩展性、可靠性和一致性等关键特性。根据节点之间的交互模式和资源组织方式,分布式系统主要采用客户端-服务器(Client-Server)架构和点对点(Peer-to-Peer, P2P)架构两种模式,实际系统往往采用混合架构以兼顾不同需求。

客户端-服务器架构采用非对称的交互模式,服务器节点集中管理和提供资源或服务,客户端节点通过网络向服务器发起请求并获取服务。这种架构的优势在于资源的集中管理和统一调度,便于实现访问控制、数据一致性和系统维护。客户端-服务器架构广泛应用于Web服务、数据库系统、文件系统等场景。然而,服务器节点可能成为性能瓶颈和单点故障源,需要通过负载均衡、集群部署和冗余设计来提升系统的可扩展性和可靠性。

点对点架构采用对称的交互模式,每个节点既可以作为资源的提供者,也可以作为资源的请求者,节点之间地位平等,直接进行数据交换和协作。P2P架构具有高度的可扩展性和容错性,新节点的加入能够增加系统的总容量,部分节点的失效不会导致系统整体瘫痪。P2P架构常见于文件共享系统(如BitTorrent)、分布式存储系统(如IPFS)和区块链网络。然而,P2P架构面临节点发现、数据一致性、安全性和性能优化等挑战。

实际工程中,许多分布式系统采用混合架构,在核心服务层采用客户端-服务器模式实现集中管理和控制,在数据层或边缘节点间采用P2P模式实现分布式存储和协作。例如,部分云服务平台在元数据管理和调度层面采用集中式架构,而在数据存储和计算任务分发层面采用分布式架构,从而兼顾系统的可控性和可扩展性。

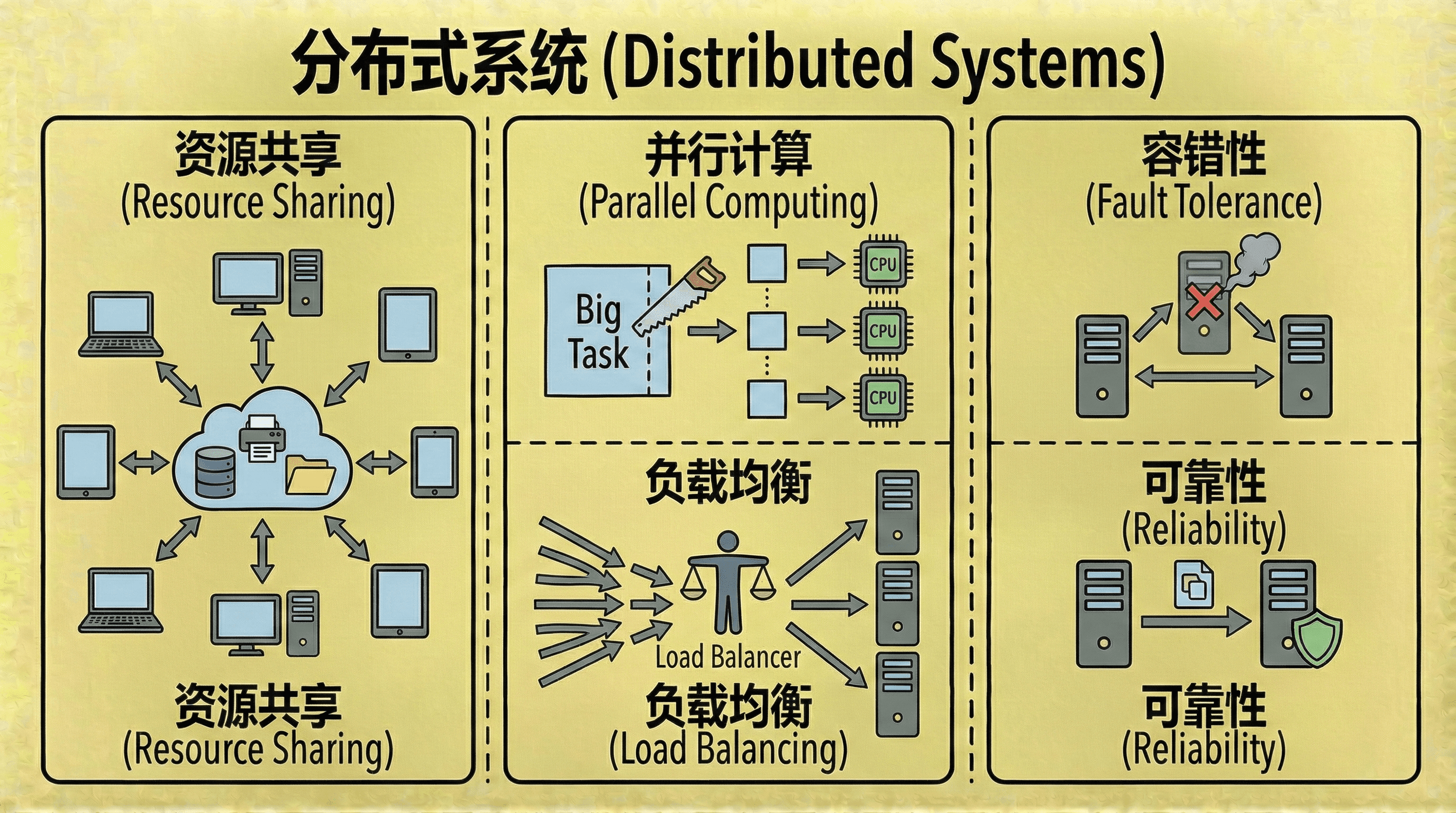

资源共享

分布式系统的核心优势之一是实现跨地理位置的资源共享,通过网络互连,用户可以访问和调度分布在不同节点的计算资源、存储设备和专用硬件。这种资源共享能力使得企业能够整合分散的资源,提高资源利用率,降低总体拥有成本(TCO)。

资源共享的实现依赖于标准化的接口和协议。远程过程调用(Remote Procedure Call, RPC)和Web服务(Web Service)等技术使得应用程序能够像调用本地函数一样调用远程服务,屏蔽了网络通信的复杂性。网络文件系统(如NFS、CIFS)使得远程文件系统能够像本地文件系统一样被访问,实现了存储资源的透明共享。虚拟化技术(如虚拟机、容器)使得计算资源能够被抽象和池化,实现动态分配和弹性扩展。

分布式资源共享不仅提高了资源利用率,还实现了资源的专业化分工。高性能计算集群可以提供强大的并行计算能力,分布式存储系统可以提供海量的存储容量,专用硬件(如GPU、FPGA)可以通过网络被多个应用共享使用。这种资源共享模式是现代云计算和大数据处理的基础。

并行计算与负载均衡

分布式系统通过将大规模计算任务分解为多个子任务,并将这些子任务分配给不同的计算节点并行执行,能够显著提升计算性能和吞吐量。这种并行计算能力使得分布式系统能够处理单机系统无法完成的大规模数据处理、科学计算和机器学习等任务。

并行计算的有效性依赖于任务的可分解性和节点间的通信开销。对于计算密集型任务,如果任务可以分解为相对独立的子任务,且子任务之间的通信量较小,则并行计算能够获得接近线性的加速比。对于数据密集型任务,分布式系统可以将数据分片存储在不同的节点上,实现数据本地性(Data Locality),减少数据传输开销。

负载均衡(Load Balancing)是分布式系统中的关键技术,它通过动态分配任务和请求,使得各个节点的负载尽可能均衡,避免部分节点过载而其他节点空闲的情况。负载均衡可以采用静态策略(如轮询、哈希)或动态策略(如最少连接、响应时间),可以在客户端、服务器端或中间件层面实现。现代负载均衡器还支持健康检查、故障转移和自动扩缩容等功能,提高了系统的可用性和弹性。

容错性与可靠性

分布式系统的可靠性通过冗余设计和容错机制实现。与单机系统不同,分布式系统假设节点故障是常态而非例外,因此系统架构必须能够在部分节点失效的情况下继续提供服务。

冗余设计包括数据冗余和计算冗余。数据冗余通过数据复制(Replication)实现,同一份数据在多个节点上保存多个副本,当某个节点失效时,可以从其他节点访问数据。数据复制可以采用主从复制(Master-Slave Replication)、主主复制(Master-Master Replication)或链式复制(Chain Replication)等策略。计算冗余通过服务副本实现,同一服务在多个节点上运行,当某个节点失效时,其他节点可以接管服务。服务副本可以采用主动-被动(Active-Passive)模式或主动-主动(Active-Active)模式。

容错机制还包括故障检测、故障恢复和一致性保障。故障检测通过心跳机制(Heartbeat)或租约机制(Lease)定期检查节点的健康状态。故障恢复包括自动故障转移(Failover)和数据恢复,确保系统能够从故障中快速恢复。一致性保障确保在节点故障和恢复过程中,系统的状态保持一致,不会出现数据丢失或不一致的情况。

然而,分布式系统的可靠性并非无条件保证。如果系统中的关键组件(如元数据服务器、协调服务)高度集中,即使采用分布式架构,也可能出现单点故障(Single Point of Failure, SPOF)。因此,分布式系统的设计需要仔细分析故障模式,通过合理的冗余和容错机制,确保关键组件的可靠性。

分布式系统的设计遵循“分而治之”(Divide and Conquer)的原则,将复杂的系统分解为相对独立的模块,通过网络互连实现协同工作。这种设计既提高了系统的可扩展性和性能,又通过冗余和容错机制增强了系统的可靠性。然而,分布式系统也面临一致性、可用性和分区容错性之间的权衡,这由CAP定理(Consistency, Availability, Partition Tolerance)所描述。

分布式文件系统

分布式文件系统(Distributed File System, DFS)是分布式系统的重要应用领域,它通过网络将文件存储和访问能力分布在多台计算机上,为用户提供统一的文件系统视图,使得用户无需关心文件的实际存储位置,即可透明地访问分布式存储资源。

分布式文件系统的核心组件包括客户端(Client)、服务器(Server)和服务(Service)。服务是提供文件操作功能的软件实体,可以运行在多台机器上,实现服务的分布式部署和负载均衡。服务器是服务在具体硬件上的实例,负责实际的数据存储、元数据管理和访问控制。客户端通过标准化的接口(如POSIX文件系统接口)发起文件操作请求,实现对分布式资源的透明访问。

分布式文件系统的显著特征在于其高度的分布性和透明性。客户端、服务器以及存储设备分布在不同的物理节点上,所有的文件操作都需要通过网络进行,这引入了网络延迟、带宽限制和网络故障等新的挑战。理想情况下,分布式文件系统应当为用户提供与本地文件系统无异的使用体验,包括位置透明性(Location Transparency)、访问透明性(Access Transparency)和故障透明性(Failure Transparency)。位置透明性指用户无需知道文件的实际存储位置;访问透明性指远程文件的访问方式与本地文件相同;故障透明性指系统能够自动处理节点故障,对用户隐藏故障细节。

在性能方面,分布式文件系统不仅要考虑传统文件系统中的存储访问延迟和CPU处理时间,还必须应对网络传输带来的额外延迟和协议处理开销。文件操作的响应时间受到网络带宽、传输距离、网络拥塞、协议效率以及服务器负载等多重因素影响。因此,设计高效的通信机制、优化数据传输路径、实现智能缓存策略和负载均衡,是提升分布式文件系统整体性能的关键技术。

DFS架构模型

分布式文件系统的架构设计直接影响系统的性能、可扩展性和可靠性。根据元数据管理和数据存储的组织方式,分布式文件系统主要采用客户端-服务器模型和集群模型两种架构。

客户端-服务器模型

客户端-服务器模型采用集中式的元数据管理和数据存储架构,所有文件数据和元数据信息都存储在服务器端,客户端通过特定的网络协议(如NFS、CIFS)向服务器发起文件访问请求。

在客户端-服务器模型中,服务器承担文件存储、元数据管理、访问控制、并发控制和一致性维护等核心功能。服务器在接收到客户端的文件访问请求后,首先进行用户身份认证和权限校验,确保只有具备相应权限的用户才能访问目标文件。服务器还负责维护文件的版本信息、时间戳、访问权限等元数据,处理多个客户端对同一文件的并发访问,确保数据的一致性和完整性。客户端则负责维护本地缓存、文件句柄状态和用户接口,通过缓存机制减少网络请求,提升访问性能。

NFS:网络文件系统

网络文件系统(Network File System, NFS)是UNIX环境下应用最广泛的分布式文件系统之一,由Sun Microsystems公司于1984年设计开发。NFS的核心理念在于实现高效的故障恢复能力,其服务器端采用无状态(Stateless)架构设计,不记录客户端的文件访问状态信息。

NFS的无状态设计使得所有操作都具备幂等性(Idempotency),即同一操作可以安全地重复执行而不改变系统状态。这种设计使得NFS能够在网络异常、请求重传或服务器重启等情况下保证数据一致性和系统稳定性。客户端负责维护自身的操作状态,如文件指针位置、打开文件列表等,服务器仅响应客户端的请求,不维护会话状态。这种设计简化了服务器的实现,提高了系统的可扩展性和容错能力。

NFS采用远程过程调用(RPC)机制实现客户端和服务器之间的通信,通过外部数据表示(XDR)实现数据的序列化和反序列化,确保不同架构的机器之间能够正确交换数据。NFS支持文件锁定、目录缓存、属性缓存等高级功能,通过版本演进(NFSv2、NFSv3、NFSv4)不断改进性能和功能。

Andrew文件系统(Andrew File System, AFS,现为OpenAFS)则以大规模可扩展性为主要设计目标,能够支持成千上万的客户端同时访问。AFS采用客户端缓存策略,将文件内容下载到客户端本地缓存,用户在本地完成文件编辑操作,只有在文件关闭时才会将修改内容同步回服务器。这种策略显著降低了服务器的请求压力,提高了整体系统的访问效率和可扩展性,非常适合大规模分布式环境下的高并发文件操作场景。AFS还实现了卷(Volume)管理和位置数据库(Location Database)等机制,支持文件的透明迁移和全局命名空间。

集群模型

当数据量和I/O负载增大时,客户端-服务器模型的单点瓶颈问题就显现出来了。服务器可能成为性能瓶颈,无法满足大规模并发访问的需求;同时,服务器也是单点故障源,一旦失效将导致整个系统不可用。集群模型通过将元数据管理和数据存储分离,采用分布式存储和集中式元数据管理来解决这些问题。

在集群模型中,元数据服务器(Metadata Server, MDS)负责维护文件系统的命名空间、文件到数据块的映射关系、访问权限等元数据信息,而数据服务器(Data Server或Chunk Server)负责存储实际的文件数据块。客户端在访问文件时,首先向元数据服务器查询文件的数据块位置信息,然后直接与对应的数据服务器进行数据交互,避免了数据通过元数据服务器转发,提高了数据传输效率。这种架构设计使得系统能够通过增加数据服务器来扩展存储容量和I/O性能,同时通过元数据服务器的冗余部署提高系统的可靠性。

Google文件系统(GFS)和HDFS

Google文件系统(Google File System, GFS)是Google为大规模数据处理应用设计的分布式文件系统,其设计充分考虑了分布式环境下的实际需求。GFS认为硬件故障是常态而非例外,因此系统架构强调容错性和高可用性,能够在节点故障、磁盘故障和网络分区等情况下继续提供服务。

GFS主要面向大文件的存储与处理,文件通常为数百MB到数GB大小,文件操作以追加(Append)为主,随机写入较少。这种访问模式简化了并发控制和一致性维护,GFS采用单主服务器(Single Master)架构管理元数据,通过租约机制(Lease)将数据块的写入权限授予主副本(Primary Chunk),由主副本协调多个副本的写入操作,确保数据一致性。GFS将文件切分为固定大小的数据块(Chunk,通常为64MB),每个数据块在多个数据服务器上保存多个副本(通常为3个),通过心跳机制监控数据服务器的健康状态,自动检测和恢复失效的数据块副本。

GFS通过重新设计应用接口,允许应用程序了解数据块的分布情况,从而优化数据访问模式。GFS还支持快照(Snapshot)和记录追加(Record Append)等高级功能,适应了大规模数据处理的场景需求。

Hadoop分布式文件系统(Hadoop Distributed File System, HDFS)是GFS理念的开源实现,广泛应用于大数据处理领域。HDFS继承了GFS的核心设计思想,包括大文件存储、数据块复制、单主节点架构等。HDFS将文件切分为多个数据块(Block,默认大小为128MB),分布存储在不同的数据节点(DataNode)上,并为每个数据块设置多份副本(默认副本数为3),以提升容错能力。名称节点(NameNode)负责维护文件系统的命名空间和文件到数据块的映射关系,数据节点负责存储实际的数据块并定期向名称节点报告数据块状态。

客户端在访问文件时,首先向名称节点查询文件的数据块位置信息,然后直接与对应的数据节点进行数据交互,实现高效的数据读写。HDFS还支持数据节点的动态加入和移除,实现了系统的水平扩展。HDFS的设计使其能够存储PB级的数据,支持数千个节点的集群部署,成为大数据处理生态系统(如Hadoop、Spark)的存储基础。

完结

这个部分我们系统梳理了网络与分布式系统的基本架构、核心原理和关键技术。我们从局域网和广域网的物理层实现、数据链路层协议和网络层路由机制谈起,分析了网络互联的层次化架构,以及路由器、交换机等关键设备在数据传输中的调度和转发作用。 我们还探讨了TCP/IP协议族的分层设计,包括传输层的TCP和UDP协议、网络层的IP协议和路由机制,以及应用层的DNS域名解析等关键技术。

在分布式系统层面,我们分析了客户端-服务器架构和点对点架构的特点和适用场景,探讨了资源共享、并行计算、负载均衡和容错性等核心机制。我们深入研究了分布式文件系统的架构模型,包括客户端-服务器模型中的NFS和AFS系统,以及集群模型中的GFS和HDFS系统,揭示了分布式文件系统在数据一致性、容错性和高可用性方面的设计思路与技术演进。

分布式系统的设计需要在一致性、可用性和分区容错性之间进行权衡,这由CAP定理所描述。实际系统的设计往往根据应用场景的需求,在强一致性、最终一致性和高可用性之间做出选择,通过合理的架构设计和算法优化,实现系统性能、可靠性和一致性的平衡。

到这里我们的操作系统学习就结束了,如果你想深入了解计算机网络的部分,我们也为你准备了专业的计算机网络课程,欢迎你前往学习。