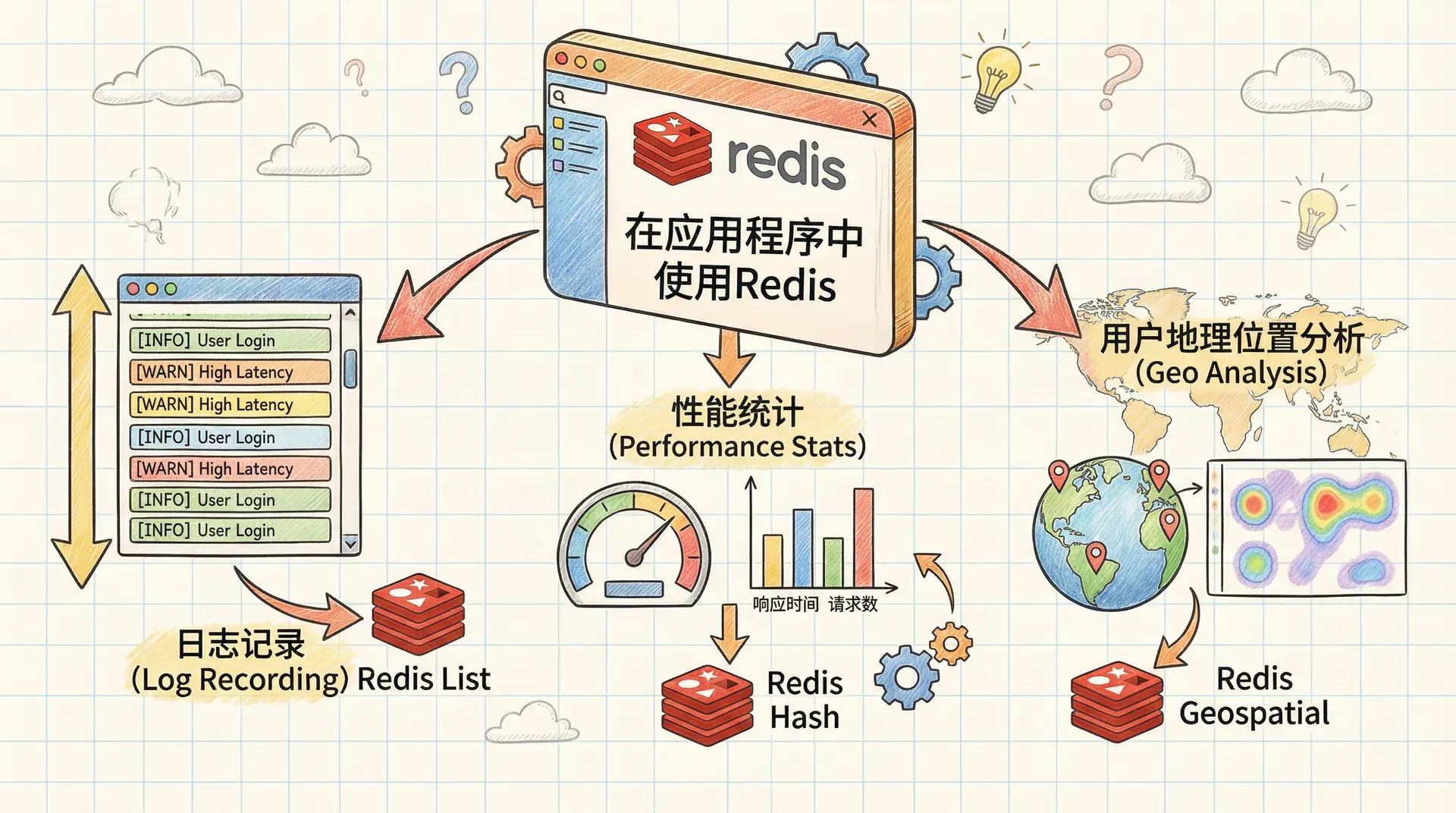

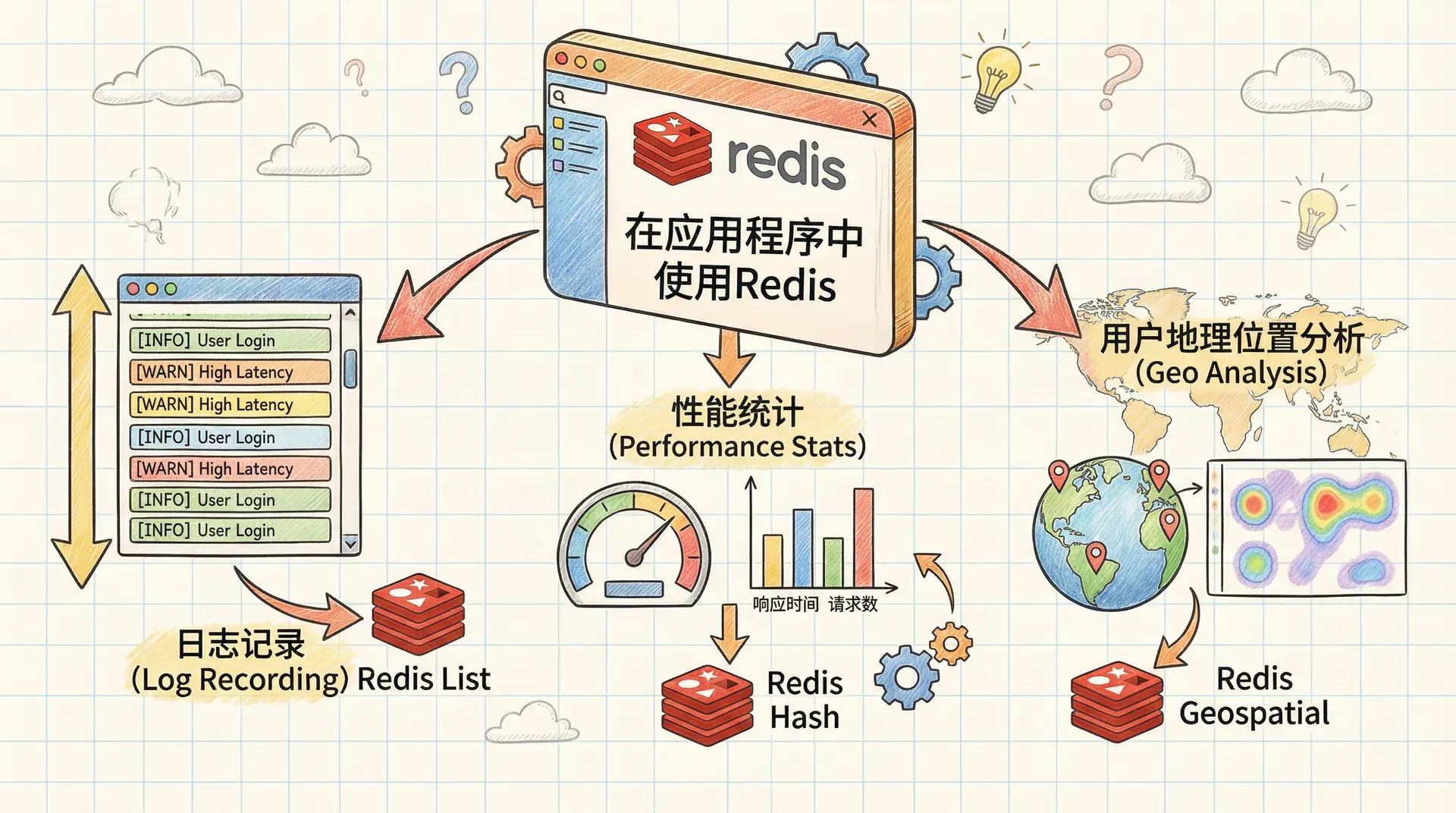

在应用程序中使用Redis | 自在学在应用程序中使用Redis

在构建复杂的应用程序时,我们常常需要深入了解系统的运行状况。这不仅仅是为了在出现问题时能够快速诊断,更是为了主动发现潜在的性能瓶颈和优化机会。Redis作为一款高性能的数据结构服务器,为我们提供了丰富的工具来收集和分析应用运行时的数据。

假设你正在运营一个热门的在线游戏平台,每天有成千上万的用户同时在线。突然之间,系统的响应速度变慢了,你需要快速找出问题的根源。是数据库查询变得缓慢?还是缓存机制出现了问题?还是某个特定地区的用户访问出现了异常?如果没有有效的监控手段,你可能会在海量的数据中迷失方向。

这就是为什么我们需要一个强大的监控系统来持续跟踪应用的健康状况。所以这节课,我们将探索如何利用Redis的各种数据结构来构建这样的监控系统,从日志记录到性能统计,再到用户地理位置分析。

日志记录

实时日志监控

在应用程序运行的过程中,日志就像是应用的眼睛,帮助我们了解正在发生什么。传统的文件日志系统虽然可靠,但是在处理大量并发请求时往往显得力不从心。我们需要一个能够实时查看最新日志信息的系统。

Redis的LIST数据结构为我们提供了一个完美的解决方案。通过LPUSH命令将新的日志消息添加到列表的头部,然后使用LTRIM命令限制列表的大小,我们可以始终保持最近100条日志消息的记录。

举个例子,假设我们正在开发一个电商网站的用户登录系统。当用户尝试登录时,我们希望记录下每次登录尝试的结果。无论是成功登录还是失败尝试,都应该被记录下来以便后续分析。

# 记录用户登录日志的示例代码

import redis

from datetime import datetime

def log_user_login(redis_client, user_id, success, ip_address):

timestamp = datetime.now().isoformat()

status = 'success' if success else 'failed'

message = f"{timestamp} - User {user_id} login {status} from {ip_address}"

redis_client.lpush('recent:login:logs', message)

redis_client.ltrim('recent:login:logs', 0, 99)

通过这样的设计,我们可以随时查看最近的登录活动。如果突然发现大量的登录失败记录,我们就可以快速定位可能的安全问题,比如遭受了暴力破解攻击。

频率分析

仅仅记录最近的日志还不够,我们还需要了解哪些类型的消息出现得最为频繁。某些错误消息可能在短时间内大量出现,这往往预示着系统出现了严重的问题。

为了实现这个目标,我们使用Redis的ZSET数据结构来记录消息的出现频率。消息本身作为成员,分数则表示该消息出现的次数。同时,为了避免数据无限增长,我们需要定期对这些统计数据进行轮转。

假设我们的电商网站有一个商品搜索功能。如果搜索功能出现了性能问题,可能会产生大量的超时错误日志。通过频率统计,我们可以快速识别出这种趋势,并在问题变得严重之前采取行动。

# 记录和分析错误日志频率的示例代码

import redis

import time

import asyncio

async def log_and_analyze_error(redis_client, error_type, error_message):

hour_key = f"errors:{int(time.time() / 3600)}"

error_key = f"{error_type}:{error_message}"

# 增加错误计数

await redis_client.zincrby(hour_key, 1

通过这种方式,我们不仅能够看到实时的错误情况,还能分析错误发生的趋势,为系统的优化提供数据支持。

计数器和统计

多维度计数器系统

在现代应用程序中,简单的计数已经无法满足我们的需求。我们需要在一个时间轴上跟踪各种指标的变化趋势,以便发现性能模式和异常情况。

Redis的HASH和ZSET数据结构的组合为我们提供了一个强大的多维度计数器系统。我们可以为不同的时间精度维护独立的计数器,从秒级到天级,每个精度都有自己独立的存储空间。

考虑一个在线视频流媒体平台,我们需要跟踪用户观看视频的情况。不仅要知道今天总共有多少观看次数,还要能够分析观看量的时段分布,以及是否出现了异常的流量高峰。

# 多维度视频观看计数器的实现

import redis

import time

class VideoViewCounter:

def __init__(self, redis_client):

self.redis = redis_client

# 定义不同的时间精度

self.precisions = [1, 5, 60, 300, 3600, 86400] # 秒、分、小时等

async def record_view(self, video_id):

now

通过引入多维度计数器系统,我们能够从不同的时间粒度全面、精确地追踪视频观看数的变化。这不仅帮助技术团队及时定位流量波动的原因,也为产品和运营提供了量化依据,实现了数据驱动的决策。

智能数据清理机制

随着业务规模扩大,Redis中的计数器数据会持续增长,如果不加以管理,海量的历史数据非常容易导致 Redis 内存压力剧增,甚至影响应用稳定性。因此,我们必须设计一套智能、自动化的数据清理方案,动态删除过期或无价值的数据,保障系统高效运行。

在实际实施过程中,智能清理机制应遵循以下专业原则:

- 时效性:数据越新价值越高,越陈旧的数据越可以考虑清除。举例来说,秒级计数器通常只对最近的几分钟甚至几十秒有意义,小时级、天级的统计数据则可适当保留更长时间。

- 访问频率:活跃、被经常访问的计数器可以优先保留,而长期无人访问的数据可更快淘汰。

- 存储成本与收益:需要根据内存消耗和业务价值做权衡,挑选最需要长期持久化的精度,减少冗余数据占用空间。

具体而言,我们可以依据时间精度(比如秒、分、小时、天)分别设定合理的保留窗口。精确度越高(如秒级、分级)的数据,通常只保留最近的一小段时间样本,而低精度数据(如日级、周级汇总)则可适当扩展保存周期。

# 计数器数据清理器的实现

import redis

import time

class CounterCleaner:

def __init__(self, redis_client):

self.redis = redis_client

self.sample_count = 120 # 保留120个样本

async def clean_counters(self):

index = 0

known_counters = await self.redis.zcard('known:')

while index

通过定期清理历史计数数据,我们既保证了每一次查询时所得到的数据都是最新鲜且具代表性的,又能够有效控制Redis的资源消耗,防止持久积累导致内存膨胀。这样的机制非常适合应对高并发和大数据量场景,确保系统响应始终高效可靠。

接下来,想要从这些原始的计数器数据中获得真正有价值的信息,就必须依赖科学的统计分析方法。简单的原始计数只能反映事件发生的次数,而只有通过深入的统计处理,我们才能洞察应用的健康状况和潜在趋势。

例如,在接口性能监控中,光看响应次数远远不够,更需要实时计算平均响应时长,观察最大值、最小值以及响应时间的波动幅度(标准差),这样才能全面把握性能表现,是不是有偶发性高延迟或者某一段时间性能下降。

在这个过程中,Redis的有序集合(ZSET)结构表现得尤为出色。它不仅能够高效地记录和更新各种指标,还支持如ZUNIONSTORE这样的聚合操作,可以在不加锁的情况下,轻松地合并和统计多个维度的数据。

借助这些Redis原生命令,我们能够实现高性能并发环境下的多维统计分析,无需担心数据一致性和性能瓶颈问题。

# 统计信息收集器的实现

import redis

import time

import math

class StatisticsCollector:

def __init__(self, redis_client):

self.redis = redis_client

async def record_response_time(self, endpoint, response_time):

context = f'api:{endpoint}'

now = int(time.time())

hour_start = (now //

IP地理位置分析

在如今高度互联的数字世界中,企业越来越重视了解自身用户的地域分布情况。这不仅是为了满足不同市场的业务扩展需求,更是出于对各地区用户行为、网络环境及文化差异的精准把控。

比如,对于国际化的电商平台而言,掌握每个国家、地区用户的访问频率和活跃度,对于制定本地化运营策略、优化服务质量乃至调配服务器资源都是非常有价值的支持信息。

通过将用户的IP地址映射到实际的地理位置,我们能够洞察每位访客的来源地,评估某些区域的流量变化,甚至预判可能有网络瓶颈的节点,实现更有针对性的业务决策和系统优化。

实现这种映射,不仅仅需要一个海量且及时的数据处理方案,更需要检索速度足够快以应对高并发访问请求。传统做法往往采用数据库表进行IP范围匹配,这类方式在数据量较大或访问压力较高时容易产生性能瓶颈。

而Redis,作为内存型高性能数据库,它的数据结构ZSET(有序集合)天然适合处理区间查找问题。通过将IPv4地址转化为一个唯一的数值分数保存到ZSET中,系统可以实现高效的范围查询,迅速定位目标IP所对应的城市或地区信息,大幅度提升整套服务的响应速度与可扩展性。

借助这样的设计,我们面对日益复杂的全球用户结构,也能用专业、简便且高效的方式洞悉和服务我们的用户群体,下面是一个示例代码:

# IP地址转换和地理位置数据库的实现

import redis

import json

class GeoLocationService:

def __init__(self, redis_client):

self.redis = redis_client

# 将IP地址转换为数字分数

def ip_to_score(self, ip_address):

parts = ip_address.split('.')

score = 0

for i in range(4):

score = score

服务发现与配置管理

在传统的应用部署中,配置信息通常被硬编码在配置文件中或者编译时确定。这种方式在面对多服务器部署、动态扩缩容或服务迁移时显得特别笨重。我们需要一个能够实时更新的配置系统,让应用能够在运行时适应变化。

Redis作为配置信息的存储层,为我们提供了一个完美的解决方案。我们可以将所有服务的连接信息、功能开关和其他配置参数存储在Redis中,应用可以实时读取这些信息。

设想一下,你正在管理一个大型的微服务架构。不同的服务可能运行在不同的服务器上,数据库连接信息可能会因为故障转移而改变。通过Redis配置系统,你可以在不重启任何服务的情况下更新这些信息。

# 动态配置管理系统的实现

import redis

import json

import time

class ConfigurationManager:

def __init__(self, redis_client):

self.redis = redis_client

self.cache = {}

self.last_update = {}

self.cache_timeout = 1000 # 1秒缓存

# 设置配置信息

async def set_config(self, service_type, service_name, config):

key

这样的设计让我们能够实现真正的配置热更新,而不需要重启应用。接下来,我们还需要一个能够自动管理数据库连接和Redis连接的系统。这个系统应该能够根据配置的变化自动重新连接到正确的服务。

装饰器模式为我们提供了一个优雅的解决方案。我们可以创建一个装饰器,在函数调用时自动提供正确的连接,并且在配置发生变化时自动更新连接,下面是一个示例代码:

# 智能连接管理装饰器的实现

import redis

import json

from functools import wraps

def create_connection_decorator(config_manager):

connections = {}

def service_connection(service_type, service_name):

def decorator(func):

@wraps(func)

async def wrapper(*args, **kwargs):

config_key = f"{service_type

通过引入这个装饰器,连接的创建、生命周期管理与配置热更新都变得自动化和无感知。开发人员可以专注于自身的业务逻辑实现,而无需手动管理底层的连接细节。

例如,任何涉及数据库访问或缓存操作的函数,在运行前都会自动检测当前连接配置是否发生变化,若存在变动则立即重新建立新连接,确保服务始终使用最新、最正确的资源。

为帮助大家直观理解这一方案,我们不妨设想一个实际开发场景。假如你的应用需同时连接多个数据库实例——主数据库用于写入,多个只读副本用于分担查询压力。

面对分布式部署、主从切换或只读节点扩容等动态调整,传统做法往往需要开发者亲自手动处理连接重建流程。

而有了上述装饰器机制,你只需更新Redis存储的配置信息,系统会自动感知变化并完成后续连接的自动切换与恢复,无需人工干预。这显著提升了系统的灵活性和稳定

# 使用装饰器的数据库服务示例

class DatabaseService:

def __init__(self, config_manager):

self.connection_decorator = create_connection_decorator(config_manager)

# 主数据库写入操作

@property

def save_user(self):

return self.connection_decorator('database', 'master')(self._save_user)

async def _save_user(self, master_connection, user_data):

query = 'INSERT INTO users (name, email) VALUES (?, ?)'

return await

现在,当数据库服务器需要迁移或者Redis集群需要重新配置时,我们只需要更新Redis中的配置信息,所有服务都会自动重新连接到正确的位置。

# 配置更新的示例

async def update_service_configuration(config_manager):

# 更新主数据库配置(故障转移)

await config_manager.set_config('database', 'master', {

'host': 'new-master-db.example.com',

'port': 5432,

'database': 'app_db',

'username': 'app_user',

'password': 'secure_password'

})

# 更新Redis集群配置

await config_manager.set_config('redis'

Redis在应用支持中的角色

本节课程我们覆盖了大量实际可用的业务代码,内容虽然有些枯燥,但每一部分都极具实用价值。从日志采集、高频事件统计、到用户地理位置分析和动态配置管理,每个知识点都能直接应用在真实的生产环境中,为系统的稳定运行和高效维护提供了坚实的技术支撑。

通过这些示例,你应该能够深刻体会到,Redis在这些基础支撑型场景中的突出优势。无论是高并发下的实时数据采集与查询,还是灵活的事件统计和配置管理,Redis都能以极低的延迟和出色的扩展性,帮助我们高效构建和维护可靠的应用基础设施。这些看似隐藏在底层的能力,正是现代大型应用能够平稳运转和快速响应变化的关键保障。

记住,技术是为业务服务的。这些监控和支持系统不仅仅是技术债务,更应该是你业务增长的加速器。合理地应用这些工具,将会让你在竞争激烈的市场中立于不败之地。

, error_key)

# 检查是否需要轮转到下一小时

current_hour = int(time.time() / 3600)

last_rotation = await redis_client.get('last_error_rotation')

if not last_rotation or int(last_rotation) < current_hour:

# 轮转数据

prev_hour_key = f"errors:{current_hour - 1}"

await redis_client.rename(hour_key, prev_hour_key + '_archive')

await redis_client.set('last_error_rotation', current_hour)

=

int

(time.time())

# 为每个时间精度记录观看次数

for precision in self.precisions:

time_slot = (now // precision) * precision

key = f"views:{precision}:{video_id}"

# 记录到已知计数器集合中

await self.redis.zadd('known:counters', {key: 0})

# 增加对应时间槽的计数

await self.redis.hincrby(f'count:{key}', time_slot, 1)

async def get_views(self, video_id, precision, time_range=24 * 3600):

key = f"views:{precision}:{video_id}"

now = int(time.time())

start_time = now - time_range

# 获取指定时间范围内的观看数据

data = await self.redis.hgetall(f'count:{key}')

views = []

for timestamp, count in data.items():

ts = int(timestamp)

if ts >= start_time:

views.append({'timestamp': ts, 'count': int(count)})

return sorted(views, key=lambda x: x['timestamp'])

<

known_counters:

# 获取下一个计数器

counter = await self.redis.zrange('known:', index, index)

if not counter:

break

counter_key = counter[0]

precision = int(counter_key.split(':')[0])

# 计算清理时间点

now = int(time.time())

cutoff = now - self.sample_count * precision

# 获取并清理过期数据

count_key = f'count:{counter_key}'

timestamps = await self.redis.hkeys(count_key)

to_remove = []

for ts in timestamps:

if int(ts) < cutoff:

to_remove.append(ts)

if to_remove:

await self.redis.hdel(count_key, *to_remove)

# 如果计数器为空,从已知集合中移除

remaining = await self.redis.hlen(count_key)

if remaining == 0:

await self.redis.zrem('known:', counter_key)

index -= 1 # 调整索引

index += 1

3600

)

*

3600

# 检查是否需要轮转到新的小时

last_hour = await self.redis.get(f'{context}:start')

if not last_hour or int(last_hour) < hour_start:

# 归档上一小时的数据

await self.redis.rename(context, f'{context}:last')

await self.redis.set(f'{context}:start', hour_start)

# 更新统计信息

stats_key = context

await self.redis.zincrby(stats_key, response_time, 'sum')

await self.redis.zincrby(stats_key, 1, 'count')

# 更新最小值和最大值

current_min = await self.redis.zscore(stats_key, 'min')

current_max = await self.redis.zscore(stats_key, 'max')

if current_min is None or response_time < current_min:

await self.redis.zadd(stats_key, {response_time: 'min'})

if current_max is None or response_time > current_max:

await self.redis.zadd(stats_key, {response_time: 'max'})

async def get_statistics(self, endpoint):

context = f'api:{endpoint}'

data = await self.redis.zrange(context, 0, -1, withscores=True)

stats = {}

for key, score in data:

stats[key] = float(score)

if stats.get('count', 0) > 0:

stats['average'] = stats['sum'] / stats['count']

# 计算标准差

sum_sq = stats.get('sumsq', 0)

variance = (sum_sq / stats['count']) - (stats['average'] ** 2)

stats['stddev'] = math.sqrt(variance)

return stats

*

256

+

int

(parts[i])

return score

# 加载IP地址到城市ID的映射

async def load_ip_ranges(self, ip_ranges):

pipeline = self.redis.pipeline()

for i, ip_range in enumerate(ip_ranges):

score = self.ip_to_score(ip_range['startIP'])

city_id = f"{ip_range['cityId']}_{i}" # 确保唯一性

pipeline.zadd('ip2cityid:', {city_id: score})

await pipeline.execute()

# 加载城市ID到地理信息的映射

async def load_city_data(self, city_data):

pipeline = self.redis.pipeline()

for city in city_data:

location_data = json.dumps([

city['city'],

city['region'],

city['country']

])

pipeline.hset('cityid2city:', city['id'], location_data)

await pipeline.execute()

# 根据IP地址查找地理位置

async def find_location_by_ip(self, ip_address):

score = self.ip_to_score(ip_address)

# 查找小于等于该分数的最大城市ID

result = await self.redis.zrevrangebyscore(

'ip2cityid:',

score,

0,

start=0,

num=1,

withscores=True

)

if not result:

return None

city_id = result[0][0].split('_')[0] # 移除唯一性后缀

location_data = await self.redis.hget('cityid2city:', city_id)

if not location_data:

return None

city, region, country = json.loads(location_data)

return {'city': city, 'region': region, 'country': country}

=

f

'config:

{

service_type

}

:

{

service_name

}

'

await self.redis.set(key, json.dumps(config))

# 获取配置信息(带缓存)

async def get_config(self, service_type, service_name):

key = f'config:{service_type}:{service_name}'

now = int(time.time() * 1000)

# 检查缓存是否仍然有效

last_update = self.last_update.get(key)

if last_update and (now - last_update) < self.cache_timeout:

return self.cache.get(key)

# 从Redis获取最新配置

config_data = await self.redis.get(key)

if not config_data:

return None

config = json.loads(config_data)

# 更新缓存

self.cache[key] = config

self.last_update[key] = now

return config

# 检查维护模式

async def is_under_maintenance(self):

config = await self.get_config('system', 'maintenance')

return config and config.get('enabled') == True

}

:

{

service_name

}

"

# 获取或创建连接

connection = connections.get(config_key)

current_config = await config_manager.get_config(service_type, service_name)

if not connection or not is_config_valid(connection.config, current_config):

# 配置已改变,创建新连接

connection = await create_connection(service_type, current_config)

connection.config = current_config

connections[config_key] = connection

# 调用原始方法,传入连接

return await func(connection, *args, **kwargs)

return wrapper

return decorator

return service_connection

async def create_database_connection(connection_string):

# 这里应该使用具体的数据库驱动,如 asyncpg, aiomysql 等

# 示例实现

pass

# 连接创建工厂

async def create_connection(service_type, config):

if service_type == 'redis':

host = config.get('host', 'localhost')

port = config.get('port', 6379)

password = config.get('password')

db = config.get('db', 0)

client = redis.Redis(host=host, port=port, password=password, db=db)

await client.ping() # 测试连接

return client

elif service_type == 'database':

connection_string = config.get('connectionString')

return await create_database_connection(connection_string)

else:

raise ValueError(f"不支持的服务类型: {service_type}")

# 配置比较函数

def is_config_valid(cached_config, new_config):

if not cached_config or not new_config:

return False

# 简单的配置比较,实际实现可能需要更复杂的逻辑

return json.dumps(cached_config, sort_keys=True) == json.dumps(new_config, sort_keys=True)

master_connection.execute(query, [user_data[

'name'

], user_data[

'email'

]])

# 只读副本查询操作

@property

def get_user(self):

return self.connection_decorator('database', 'replica')(self._get_user)

async def _get_user(self, replica_connection, user_id):

query = 'SELECT * FROM users WHERE id = ?'

return await replica_connection.query(query, [user_id])

# Redis缓存操作

@property

def get_cached_user(self):

return self.connection_decorator('redis', 'cache')(self._get_cached_user)

async def _get_cached_user(self, cache_connection, user_id):

cached = await cache_connection.get(f'user:{user_id}')

return json.loads(cached) if cached else None

@property

def set_cached_user(self):

return self.connection_decorator('redis', 'cache')(self._set_cached_user)

async def _set_cached_user(self, cache_connection, user_id, user_data):

await cache_connection.setex(f'user:{user_id}', 3600, json.dumps(user_data))

,

'cache'

, {

'host': 'redis-cluster.example.com',

'port': 6379,

'password': 'redis_password',

'cluster': True

})

# 启用维护模式

await config_manager.set_config('system', 'maintenance', {

'enabled': True,

'message': '系统正在进行例行维护,请稍后再试'

})