深度学习导论

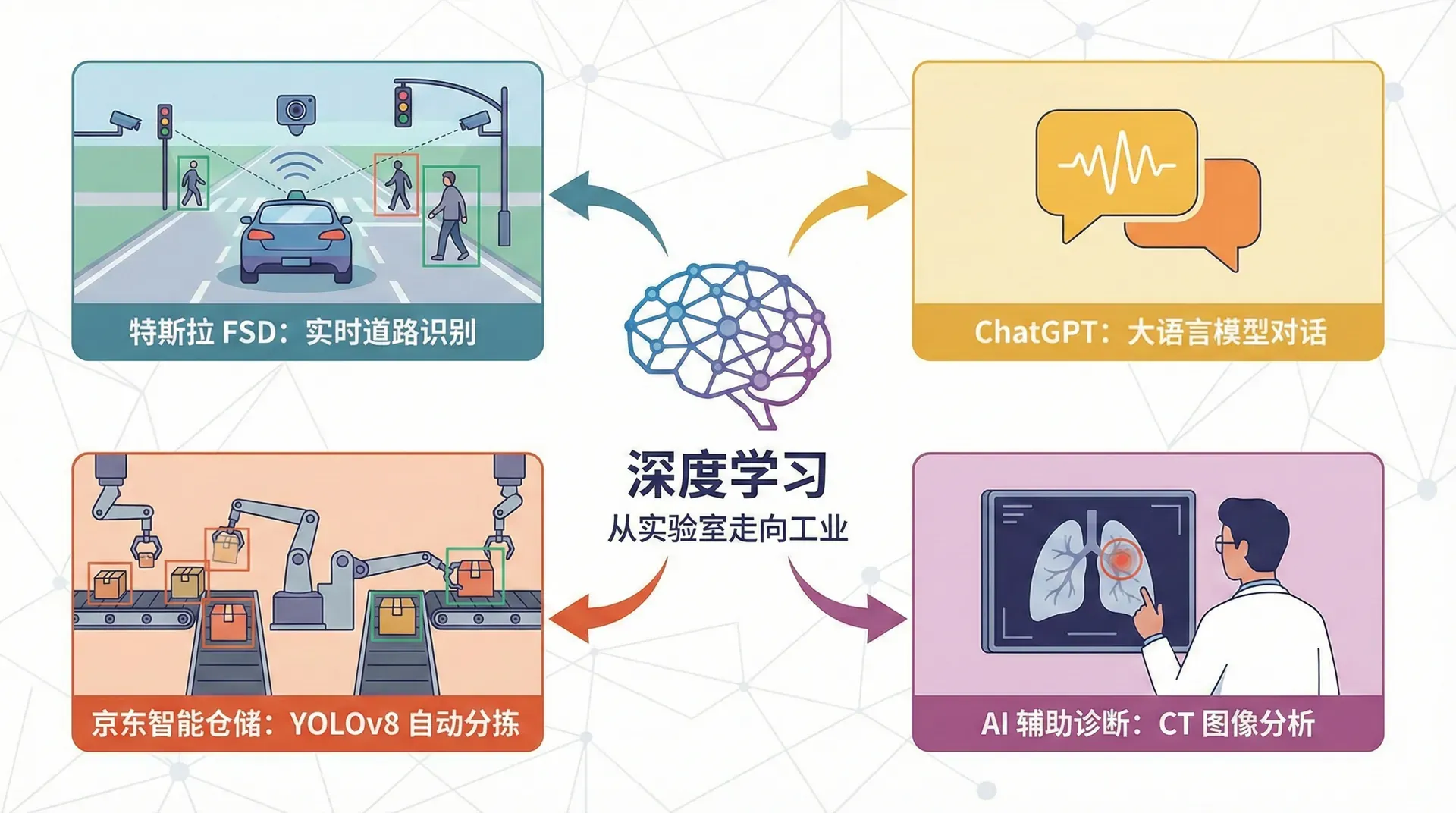

2024年,特斯拉的Full Self-Driving系统每天处理着数百万张道路图像,实时识别行人、车辆和交通标志。同一年,ChatGPT让全球见识了大语言模型的威力,能与人类进行几乎无缝的对话。在中国,京东的智能仓储系统使用YOLOv8每秒分析数千个包裹,自动完成分拣;医院的AI辅助诊断系统通过分析CT扫描图像,帮助医生发现肺部的微小病变。

这些看似神奇的应用,背后都基于同一个技术基础:深度学习。但深度学习究竟是什么?它为何能在短短十几年间从实验室走向工业界的方方面面?

深度学习的本质

传统的图像识别系统需要工程师手工设计特征提取器。想象你要识别一张图片里是否有猫,你可能会编写规则:检测尖尖的耳朵、胡须的纹理、圆形的眼睛。这种方法的问题在于,不同品种的猫长相差异巨大,光线、角度、背景的变化都会让规则失效。工程师需要为每个场景精心设计特征,这个过程既耗时又难以泛化。

深度学习彻底改变了这个游戏规则。它不再需要人工设计特征,而是让神经网络自己从数据中学习。你只需要给它数万张标注好的猫和非猫的图片,神经网络会自动发现:第一层可能学会检测边缘和纹理,第二层组合这些边缘形成耳朵、眼睛等局部特征,第三层再将这些局部特征组合成完整的猫脸。这种层次化的特征学习是深度学习的核心优势。

更重要的是,深度学习实现了端到端的学习。从原始像素到最终的“是猫”或“不是猫”判断,整个过程在一个统一的框架下优化。不需要分阶段调试,不需要在特征提取和分类器之间反复迭代。这种端到端的特性让深度学习能够处理越来越复杂的任务。

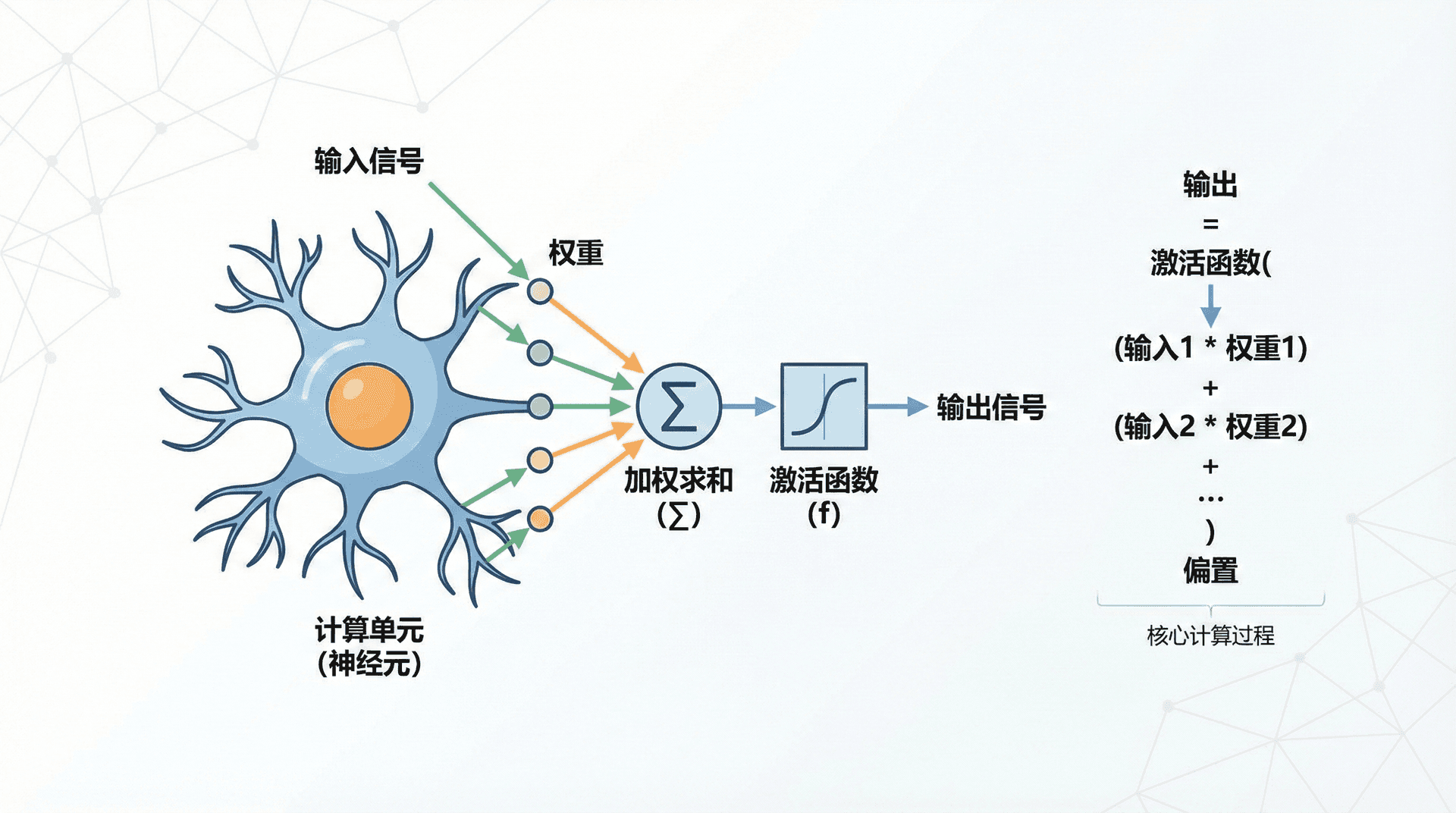

神经网络的计算单元

要理解深度学习,我们需要从最基本的构建块开始:神经元。一个神经元的计算过程非常简单,它接收多个输入,对每个输入赋予不同的权重,然后求和并加上一个偏置项:

这个 值本身可能是任意实数,为了让它表达更丰富的信息,我们再通过一个非线性的激活函数 进行变换:

这里的权重 和偏置 就是神经网络需要学习的参数。通过调整这些参数,神经元可以学会对不同的输入模式做出不同的响应。

让我们用一个实际例子来理解这个过程。假设你在一家房地产公司工作,需要预测房价。最简单的模型只考虑房屋面积这一个因素,但有一个约束:房价不能为负。我们可以用一个神经元来建模这个关系,使用ReLU(Rectified Linear Unit)激活函数来确保输出非负:

|import numpy as np import matplotlib.pyplot as plt def relu(z): """ReLU激活函数:确保输出非负""" return np.maximum(0, z) def predict_price(size, w=0.5, b=-50): """ 根据房屋面积预测房价 在真实应用中,这个模型会从数据中学习w和b的值 这里我们假设:w=0.5(每平米0.5万元) b=-50(小于100平米的房子预测价格为0) """ z = w *

但真实的房价预测远比这复杂。房价不仅取决于面积,还受到地段、学区、交通便利性、房龄等多个因素的影响。这时候,我们需要多个神经元协同工作。

想象这样一个场景:第一层的神经元各自学习不同的中间特征——有的学习“是否适合家庭居住”(基于房间数量和面积),有的学习“交通便利性”(基于地铁站距离),有的学习“学区质量”(基于邮政编码)。第二层的神经元再综合这些中间特征来预测最终房价。

这种多层结构的神奇之处在于:你不需要告诉网络“什么是适合家庭”或“什么是好学区”,它会从数据中自动学会这些抽象概念。这就是深度学习中“表示学习”的威力。

从房价预测到工业质检

2026年的今天,深度学习已经深入到各个工业领域。让我们看几个真实的应用案例,理解不同场景下如何选择合适的神经网络架构。

工业质检的自动化革命

在传统制造业中,产品质检依赖人工目视检查,不仅效率低下,而且容易疲劳出错。现在,基于卷积神经网络(CNN)的视觉检测系统改变了这一切。流水线上的摄像头实时拍摄产品图像,CNN模型能在毫秒级别内检测出划痕、裂纹、变形等缺陷。

ResNet和VGGNet这类深层网络能够自动提取产品的多层次特征:浅层学习基本的纹理和边缘,深层学习复杂的缺陷模式。某汽车零部件工厂部署这套系统后,检测准确率从人工的92%提升到99.2%,误报率降低了80%。

垃圾分类的智能识别

城市垃圾分类一直是个难题。2025年开始部署的YOLOv8目标检测系统能够实时识别不同类型的垃圾。系统不仅使用CNN提取视觉特征,还结合双向LSTM分析投放行为的时序模式——比如识别违规连续投放大件垃圾的行为。

这个系统的架构设计值得关注:CNN负责"看"(识别垃圾类型),LSTM负责"记忆"(分析行为序列),注意力机制负责"聚焦"(在复杂背景中定位关键区域)。这种混合架构体现了深度学习的模块化思想。

不同任务需要不同的网络架构

选择合适的神经网络架构是深度学习工程化的关键。下表总结了常见场景的选择:

结构化数据与非结构化数据的处理差异

深度学习最大的突破在于处理非结构化数据。对于结构化的表格数据(如Excel中的客户信息),传统的梯度提升树(XGBoost、LightGBM)往往效果更好、训练更快。但对于图像、语音、文本这类非结构化数据,深度学习有着压倒性的优势。

这是因为图像的像素之间存在强烈的空间关联性(相邻像素往往相似),文本的单词之间存在时序依赖性(前后文影响语义)。深度学习的层次化结构天然适合捕捉这些复杂的关联模式。

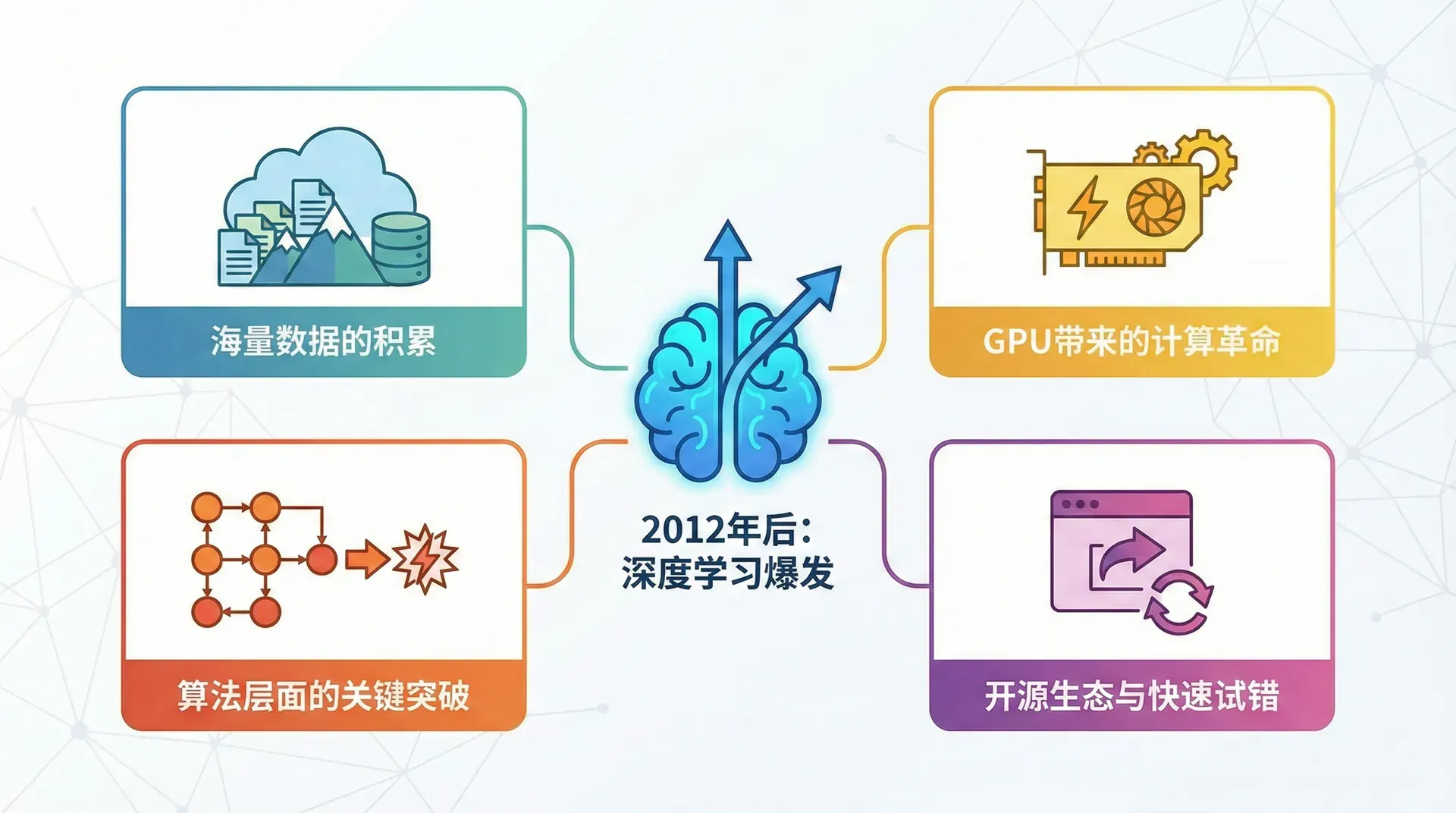

深度学习为何在2012年后爆发

神经网络的理论基础早在1980年代就已经建立,但为什么直到2012年才迎来爆发式发展?这背后有四个关键因素的相互促进。

海量数据的积累

深度学习是数据驱动的技术,它的性能提升曲线与传统方法截然不同。逻辑回归、支持向量机这类传统算法,在数据量达到某个阈值后性能就会饱和——再多的数据也无法带来明显提升。但大型神经网络展现出了惊人的"数据胃口":只要有足够的数据,性能就能持续提升。

2010年之前,即使是最大的数据集也只有数万条样本,这个规模下神经网络相比传统方法并无优势。但进入移动互联网时代后,数据量呈指数级增长。ImageNet包含140万张标注图像,YouTube每天上传的视频时长超过50万小时,Facebook用户每天上传3.5亿张照片。这些海量数据为训练大型神经网络提供了燃料。

更重要的是,深度学习模型能够"消化"这些数据。2015年的ResNet有152层、6000万个参数,2020年的GPT-3有1750亿个参数。参数量的增长意味着模型容量的提升,能够学习更复杂的模式。这就是为什么在ImageNet数据集上,错误率从2010年的28%降到了2015年的3.6%——超越了人类水平。

GPU带来的计算革命

训练一个152层的ResNet,如果用CPU需要几个月时间。这在实际项目中完全不可行——谁会等几个月才知道一个想法是否有效?

2012年是一个转折点。Alex Krizhevsky使用两块NVIDIA GTX 580 GPU训练AlexNet,在ImageNet竞赛中取得了惊人的效果。GPU的并行计算架构天然适合神经网络的矩阵运算:一个典型的卷积操作需要将每个滤波器与图像的每个位置做点积,这些计算彼此独立,可以完美并行。GPU能够同时执行数千个这样的计算,训练速度比CPU快10-100倍。

现在的情况更加乐观。NVIDIA的A100 GPU专门为深度学习优化,拥有6912个CUDA核心和312 TFLOPS的计算能力。Google的TPU v4提供了更极致的性能优化。云计算平台让即使是初创公司也能按需租用这些强大的硬件。

算法层面的关键突破

有两个看似简单的改进,彻底改变了深度学习的训练效率。

第一个是ReLU激活函数。在此之前,神经网络普遍使用Sigmoid或tanh激活函数,但它们有个致命问题:当输入的绝对值较大时,梯度接近零,导致"梯度消失"——网络的前几层几乎学不到东西。ReLU的定义非常简单:,但它的梯度要么是0,要么是1,不会衰减。这个简单的改动让训练深层网络成为可能。

第二个是Batch Normalization(批归一化)。深层网络的训练非常不稳定,前一层的参数更新会导致后一层输入分布的变化,这种"协变量偏移"问题严重拖慢训练。批归一化通过标准化每层的输入分布,让训练过程稳定得多,同时还带来了正则化效果。

此外,Dropout随机关闭神经元防止过拟合,残差连接让训练上百层的网络成为可能,注意力机制让模型能够聚焦于重要信息。这些创新虽然各自独立,但组合起来产生了协同效应。

开源生态的繁荣

2015年,Google开源了TensorFlow,Facebook随后开源了PyTorch。这两个框架降低了深度学习的门槛:你不需要手写反向传播算法,不需要处理GPU的底层细节,只需要定义网络结构,框架会自动处理训练过程。

更重要的是预训练模型的共享。ResNet、BERT、GPT的作者不仅发表论文,还公开了训练好的权重。这意味着你可以在这些巨人的肩膀上起步——通过迁移学习,只需要少量数据就能在特定任务上取得良好效果。一个医学影像项目不需要从零开始训练,可以加载在ImageNet上预训练的ResNet,然后在医学图像上微调,这样可能只需要几千张图片就够了。

开源社区还形成了快速迭代的文化。新的架构和技术通常在arXiv论文发布的同时就公开了代码。Kaggle这样的竞赛平台让来自世界各地的工程师分享经验。这种开放协作的氛围加速了整个领域的进步。

快速试错的能力

这四个因素组合起来,带来了一个更深层的改变:研究者能够快速验证想法。在2010年之前,训练一个神经网络可能需要几周,发现效果不好后再尝试新的想法,一个研究周期可能耗时数月。现在,借助GPU和高效的框架,从提出想法到看到实验结果可能只需要几个小时。

这种快速迭代能力是深度学习能够快速发展的根本原因。ResNet的作者何恺明在论文中提到,他们尝试了数十种不同的残差连接方式,最终找到了最有效的那一种。如果每次实验需要一个月,这种大规模的试错是不可能的。

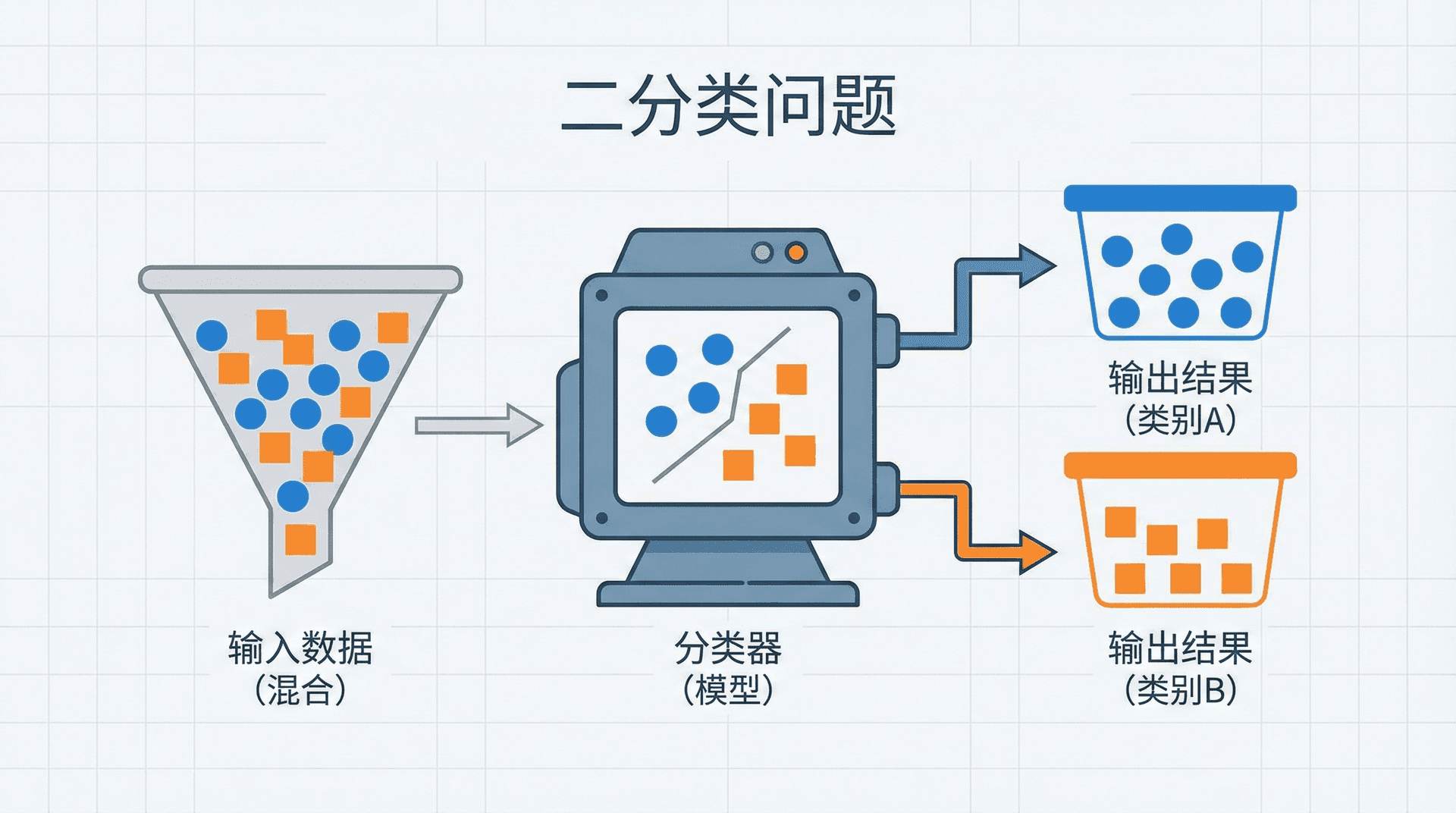

二分类问题

深度学习虽然能处理复杂任务,但理解它最好从最简单的问题开始:二分类。给定一个输入,判断它属于两个类别中的哪一个。

这个看似简单的任务有着广泛的应用。你的邮箱每天自动识别垃圾邮件,银行系统评估贷款申请是否批准,医院的AI系统判断病变是良性还是恶性,信用卡公司实时检测交易是否存在欺诈。这些都是二分类问题。

让我们以贷款审批为例理解二分类的数学建模。假设银行收集了每个申请人的信息:年收入、信用评分、负债率、工作年限等。这些信息构成了特征向量 ,其中 是特征的数量。我们的目标是预测一个二值标签 :1表示批准贷款,0表示拒绝。

训练集由 个这样的样本组成:

这里的上标 表示第 个样本,不是指数运算。为了高效计算,我们将这些样本组织成矩阵形式—— 的每一列是一个样本, 是对应的标签:

图像分类中的数据表示

贷款审批的特征是人工设计的,但图像分类直接使用原始像素。一张64×64的彩色图片有3个通道(RGB),共12,288个像素值。我们将这个三维数组展平成一个12,288维的向量。这看起来维度很高,但实际应用中常见的224×224图像有150,528个维度,更大的图像甚至可能有数百万维。

这就是为什么深度学习如此重要:传统方法很难处理如此高维的输入,而卷积神经网络通过局部感受野和参数共享,能够高效地处理这些高维数据。

|import numpy as np from PIL import Image def image_to_vector(image_path): """ 将图像转换为神经网络的输入向量 在实际项目中,这通常是数据预处理管道的第一步。 除了展平,还需要进行归一化、数据增强等操作。 """ # 读取图像并调整到统一大小 img = Image.open(image_path).resize((64, 64)) # 转换为NumPy数组:shape为(64, 64, 3) img_array = np.array(img) # 展平为一维向量:shape变为(12288, 1) x =

逻辑回归

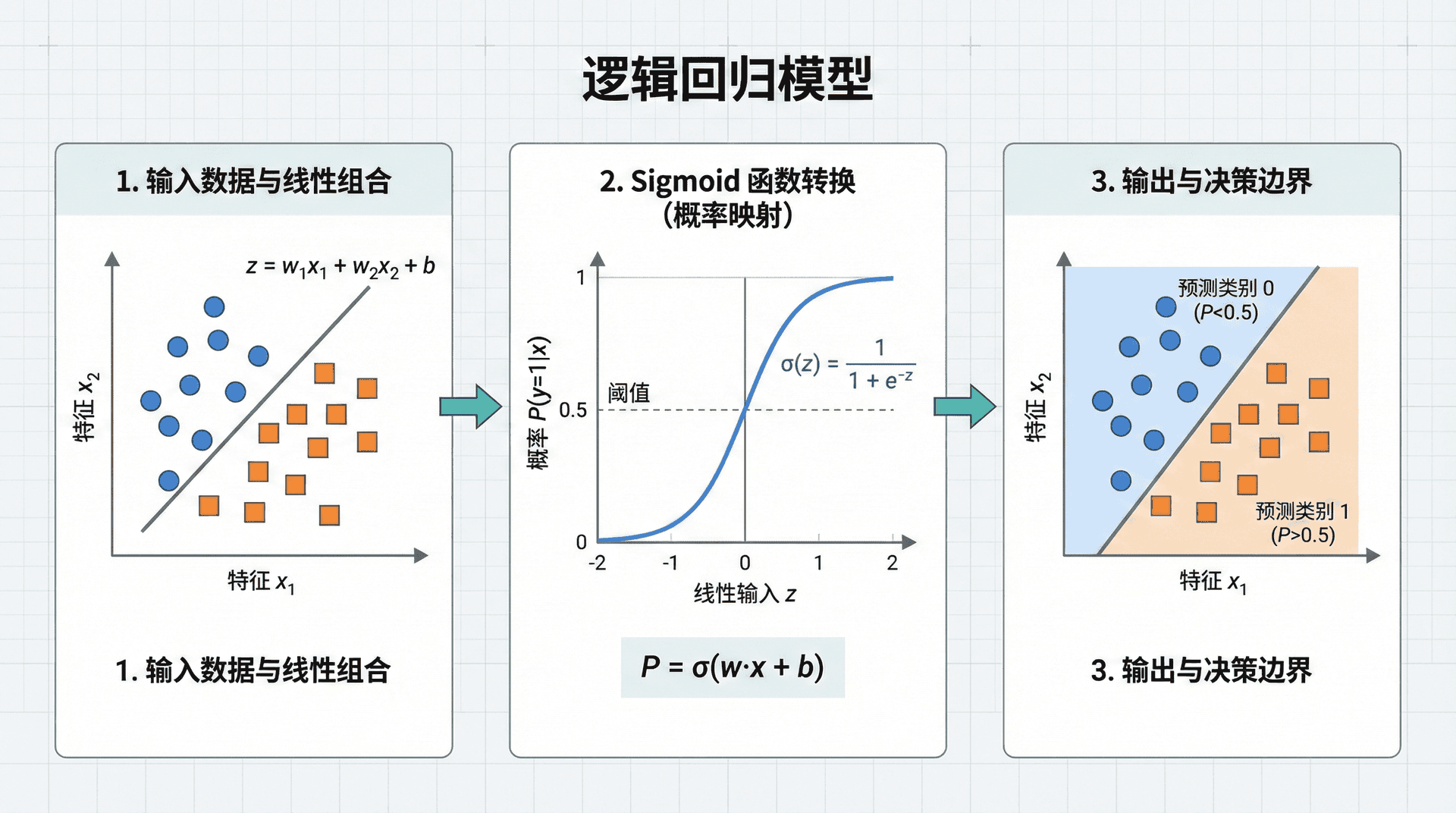

面对二分类问题,最直接的想法可能是线性回归:。但这有个问题:线性回归的输出可以是任意实数,而我们需要的是一个概率值,表示样本属于正类的可能性。

逻辑回归通过引入Sigmoid函数解决了这个问题。Sigmoid函数 有一个优美的性质:无论输入 是什么值,输出都在(0, 1)区间内,恰好可以解释为概率。

当 是一个很大的正数时, 接近0,所以 接近1。当 是一个很大的负数时, 非常大,所以 接近0。当 时,,这成为了自然的决策边界。

|import numpy as np import matplotlib.pyplot as plt def sigmoid(z): """ Sigmoid激活函数 这个函数在深度学习中无处不在,虽然在隐藏层ReLU更常用, 但在二分类的输出层,Sigmoid仍然是标准选择。 """ return 1 / (1 + np.exp(-z)) # 可视化Sigmoid函数的性质 z = np.linspace(-10, 10, 200)

逻辑回归模型的完整形式是:

这里 是权重向量, 是偏置项,它们都是需要从数据中学习的参数。 的含义是:给定输入 ,模型预测它属于正类的概率。

逻辑回归在信贷风控中的应用

让我们看一个真实的应用场景。某银行建立了一个贷款违约预测模型,特征包括:

- : 年收入(万元)

- : 信用评分(300-850)

- : 负债收入比

- : 工作年限

训练后的模型参数可能是:,。对于一个申请人:收入30万、信用评分700、负债收入比0.4、工作5年,模型的计算过程是:

模型认为这个申请人有97.5%的概率不会违约,远高于0.5的阈值,因此批准贷款。

注意权重的符号:负债收入比的权重是-2.3,说明负债越高违约风险越大;而收入和工作年限的权重为正,说明它们与还款能力正相关。这种可解释性是逻辑回归相比复杂神经网络的一个优势,在金融领域尤其重要——监管机构往往要求模型的决策是可解释的。

决策边界的几何意义

决策边界是指 的那些点,由于 ,这等价于 。在二维特征空间中,这是一条直线;在三维空间中是一个平面;在高维空间中是一个超平面。

这揭示了逻辑回归的局限:它只能学习线性决策边界。如果数据本身不是线性可分的(比如异或问题),单层逻辑回归就无能为力了。这正是我们需要深度神经网络的原因——通过堆叠多层非线性变换,网络可以学习任意复杂的决策边界。

|def plot_decision_boundary(w, b, X_pos, X_neg): """ 可视化逻辑回归的决策边界和样本分布 在实际项目中,这种可视化能帮助我们理解模型的行为, 发现潜在的问题(比如某类样本是否被系统性地误分类) """ plt.figure(figsize=(10, 7)) # 绘制样本点 plt.scatter(X_pos[:, 0], X_pos[:, 1], c='#2E86AB', marker='o', s=50, alpha=

符号约定的重要性

在深度学习的文献中,符号约定可能让初学者困惑。这里我们明确:

- :训练样本总数(如10,000个贷款申请)

- :特征维度(如4个特征:收入、信用、负债比、工作年限)

- :第 个样本的特征向量(上标表示索引,不是幂次)

- :所有样本按列堆叠成的矩阵

从逻辑回归到深度网络

现在我们理解了最简单的神经网络模型——逻辑回归。它本质上是一个单层神经网络,只有输入层和输出层,没有隐藏层。但它已经展示了神经网络的核心思想:通过可学习的参数(权重和偏置)将输入映射到输出,通过非线性激活函数增强表达能力。

逻辑回归的局限也很明显:线性决策边界无法处理复杂模式。在下一节课中,我们将学习如何通过增加隐藏层来突破这个限制,理解梯度下降如何自动学习这些参数,以及为什么反向传播算法是深度学习的核心。

我们还将看到,从单层到多层的跨越不仅是量变,更是质变——深层网络能够学习层次化的表示,这是它们能够解决复杂现实问题的关键。

思考与实践

在继续学习之前,思考以下问题能够加深理解:

为什么深度学习在小数据集上可能不如传统方法?

假设你只有100个贷款申请的历史数据,应该用深度神经网络还是逻辑回归?深度网络有数百个参数,100个样本根本无法充分训练这些参数,很容易过拟合——在训练集上表现完美,但在新数据上一塌糊涂。相比之下,逻辑回归只有几个参数,反而能在小数据集上表现更好。这就是为什么数据量是选择模型复杂度的关键因素。

Sigmoid函数的导数有什么特殊性质?

动手推导一下:。这个性质非常优美——Sigmoid的导数可以用自己表示,这让反向传播的计算变得高效。更重要的是,当 接近0或1时,导数接近0,这就是“梯度饱和”现象,也是后来ReLU激活函数流行的原因之一。

如何理解“端到端学习”的价值?

想象你要构建一个语音识别系统。传统方法需要先提取MFCC特征,然后用GMM建模音素,再用HMM处理时序,最后用语言模型纠错——每个模块独立优化。而端到端的深度学习直接从原始音频波形到文字输出,所有模块联合优化。哪种方式更好?端到端的优势是避免了模块间的信息损失,但缺点是需要更多数据、更难调试。工业界往往需要在两者之间权衡。

在下一节课中,我们将深入神经网络的数学基础,理解如何训练这些模型。我们将看到,虽然概念简单,但让神经网络在实践中工作良好需要许多技巧和经验——这正是深度学习工程化的魅力所在。