机器学习策略(上)

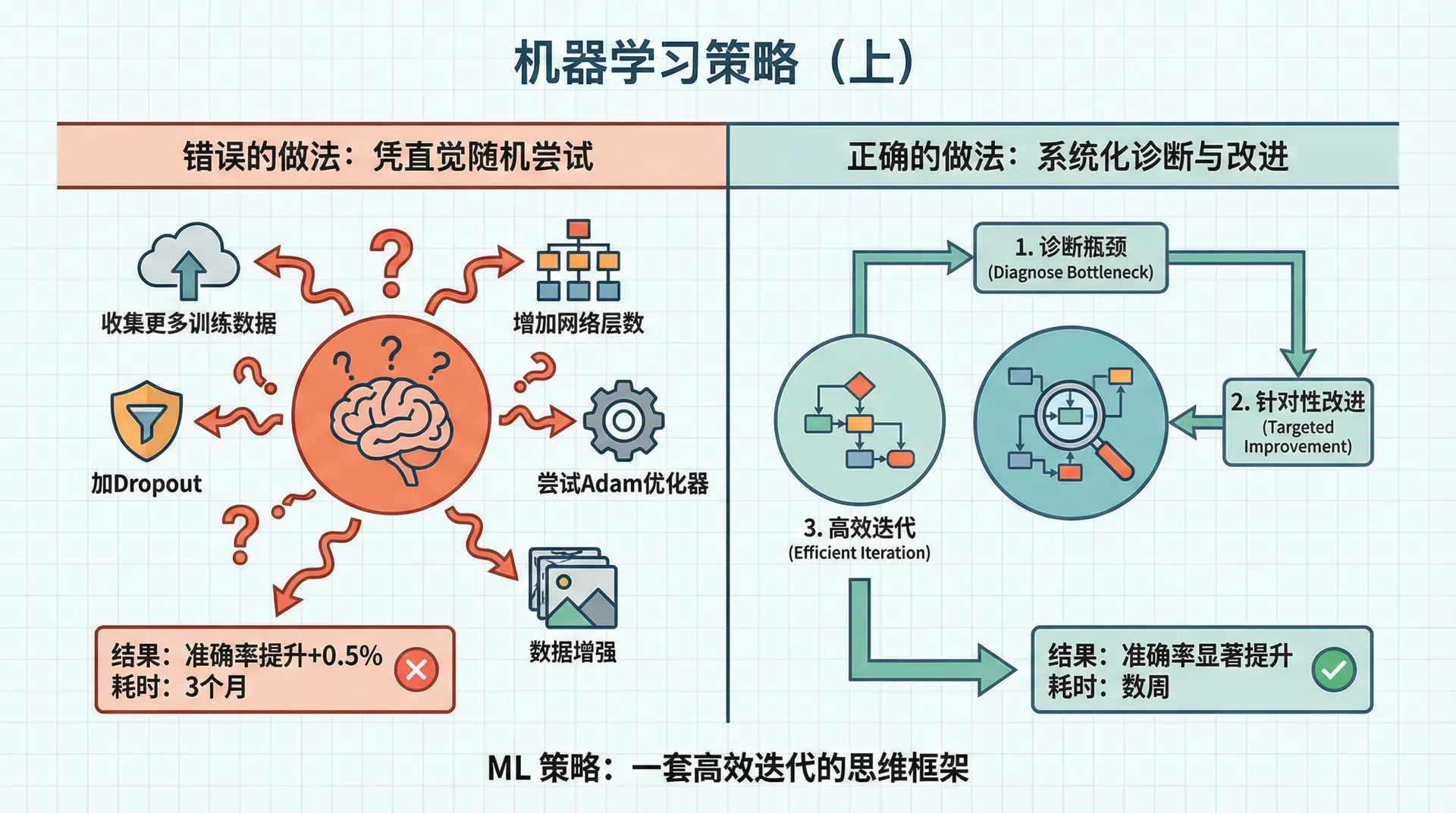

你花了三个月时间实现一个语音识别系统,准确率达到85%。不够理想。你有十几个改进想法:收集更多训练数据、增加网络层数、尝试Adam优化器、加Dropout、数据增强...每个想法都需要几周时间验证。如何决定优先做什么?

错误的做法是凭直觉随机尝试。可能花三个月收集数据,发现只提升0.5%;或者调了半天超参数,发现问题根本不在这。正确的做法是系统化地诊断问题,找到瓶颈在哪,然后有针对性地改进。这就是机器学习策略——不是新算法,而是一套高效迭代的思维框架。

正交化

老式电视机有多个旋钮:亮度、对比度、音量、频道。每个旋钮只影响一个维度,调亮度不会改变音量。这就是正交化——控制互不干扰。

机器学习也需要正交化思维。不同问题需要不同解决方案,不要用一个办法解决所有问题。

典型的性能指标链条:

- 训练集表现:模型能否拟合训练数据?

- 验证集表现:模型能否泛化到新数据?

- 测试集表现:验证集的优化是否真实?

- 实际应用表现:在真实场景下效果如何?

每个环节的问题有不同的解决方案:

训练集表现差(高偏差):

- 更大的网络(更多层或神经元)

- 训练更久

- 更好的优化算法

验证集表现差但训练集好(高方差):

- 更多训练数据

- 正则化(L2、Dropout)

- 改变网络架构

测试集表现差但验证集好:

- 更大的验证集(可能验证集太小不具代表性)

- 确保验证集和测试集来自同一分布

实际应用表现差但测试集好:

- 改变测试集的定义(可能测试集不代表真实场景)

- 改变代价函数(可能优化的指标与实际需求不一致)

Early Stopping虽然有效,但它同时影响多个维度(既影响训练集拟合,又影响泛化),违反了正交化原则。Andrew Ng更推荐L2正则化——只影响泛化,不影响优化过程。

单一数字评估指标

假设你在开发猫识别App,尝试了两个模型:

哪个更好?模型A召回率高,模型B精确率高。无法直接比较。这会让决策陷入僵局——每次尝试新模型都要权衡多个指标。

解决方案是定义单一数字评估指标,比如F1 score(精确率和召回率的调和平均):

现在很清楚:选择A。

为什么需要单一指标? 因为它能让你快速做决策。如果有10个模型候选,看一个数字就能排序,而不是纠结于多维权衡。

但有时候单一指标不够。比如一个模型F1很高但推理需要10秒,实时应用不可接受。这时候用满足条件+优化指标:

- 优化指标:最大化F1 score

- 满足指标:推理时间 < 100ms,模型大小 < 50MB

只考虑满足所有约束的模型,在这些模型中选择优化指标最好的。

训练/验证/测试集的分布

这是个常被忽视但非常重要的问题。假设你在做一个手机App的猫识别:

错误的划分:

- 训练集:网上下载的高质量猫图片(10万张)

- 验证集:美国用户上传的照片(5000张)

- 测试集:中国用户上传的照片(5000张)

问题在哪?验证集和测试集来自不同分布。你在验证集上优化超参数,但测试集分布不同,优化可能无效。

正确的划分:

- 训练集:网上下载的高质量图片(10万张)

- 验证集 + 测试集:随机混合美国和中国用户的照片,然后分成验证集和测试集

关键原则:验证集和测试集必须来自同一分布,且这个分布应该是你最关心的目标分布。训练集可以来自不同分布(比如网上下载的图片),但验证/测试集一定要代表真实应用场景。

验证集和测试集要多大?

传统做法是70/30或60/20/20。但在大数据时代,这已经过时。

假设你有100万张图片。20%的测试集就是20万张,远超评估性能所需——实际上1万张就足够得到可靠的评估。那剩下的19万张应该用于训练。

现代推荐(百万级数据):

- 训练集:98-99.5%

- 验证集:0.25-1%

- 测试集:0.25-1%

有时候甚至不需要测试集——如果数据量小或不是发布正式产品,只用训练集和验证集就够了。测试集的作用是给出无偏的最终评估,避免在验证集上过度优化。

人类水平表现

深度学习在很多任务上已经达到或超越人类水平。理解“人类水平”能帮助我们设定合理的期望,并诊断模型的瓶颈。

贝叶斯最优误差(Bayes Optimal Error)是理论上的最低误差——考虑到数据本身的噪声,任何模型都无法低于这个误差。比如医学影像诊断,即使是最好的医生也有5%的误诊率(因为有些图像确实无法判断),那么5%就是贝叶斯误差。

人类水平通常接近贝叶斯误差(在人类擅长的任务上)。这给了我们一个参考点:

场景1:超越人类前

- 人类水平(~贝叶斯误差):1%

- 训练集误差:5%

- 验证集误差:6%

分析:训练集误差5%,离人类的1%还有4个百分点差距。这4%是可避免偏差(Avoidable Bias)——理论上可以通过改进模型消除。而验证集只比训练集高1%,方差不是主要问题。

策略:专注减少偏差(更大网络、更长训练),不用太担心过拟合。

场景2:接近人类水平

- 人类水平:0.5%

- 训练集误差:0.6%

- 验证集误差:0.8%

分析:训练集误差0.6%,只比人类高0.1%,可避免偏差很小。但验证集比训练集高0.2%,方差是主要问题。

策略:专注减少方差(正则化、更多数据),提升模型空间有限。

人类水平不是唯一的。在医疗诊断中:

- 普通医生:5%误差

- 经验丰富的医生:3%误差

- 专家团队:2%误差

用哪个作为人类水平?取决于目标。如果目标是超越普通医生,用5%;如果想达到专家水平,用2%。通常选择你想超越的那个水平。

错误分析:找到改进方向

你的猫分类器在验证集上有10%误差。有人建议你改进对狗的识别(因为很多狗被误判为猫)。值得投入几周时间吗?

在动手前,先做错误分析:人工检查100个错误样本,统计有多少是因为识别狗造成的。

结果发现:100个错误样本中,只有5个是狗。即使你完美解决狗的问题,误差最多从10%降到9.5%——提升有限。相比之下,如果发现50个错误样本是模糊图片,改进模糊图片处理能将误差降到5%,收益大得多。

系统化的错误分析流程:

- 收集约100个验证集的错误样本

- 创建电子表格,列出可能的错误类型

- 逐个检查样本,标记属于哪些类型

- 统计每种类型的占比

- 优先解决占比最大的问题

结论:优先改进对模糊图片的处理(可能提升6.1%),而不是花时间处理狗(最多提升0.8%)。

这个简单的流程能避免浪费时间在低收益的方向。花几个小时做错误分析,能节省几个月的无效开发。

错误分析的价值

Andrew Ng分享过一个经历:团队花了三个月改进某个特定问题,结果只提升了0.3%。如果事先做两小时错误分析,会发现这个问题只占错误样本的5%,不值得投入。

错误分析不仅节省时间,还能让你对系统有深入理解——哪些情况模型做得好,哪些做得差,为什么。

快速迭代

机器学习项目的不确定性很高。一个想法是否有效,往往只有实现并测试后才知道。因此,快速迭代比一开始就追求完美更重要。

推荐的开发流程:

- 快速搭建初始系统(几天到一周):用简单模型、标准架构,快速得到baseline

- 评估和错误分析:看模型在哪里失败,发现主要问题

- 有针对性地改进:根据错误分析,解决最大的瓶颈

- 重复:每次改进后重新评估,找到新的瓶颈

不要在一开始花几个月设计复杂系统。先用最简单的方法得到一个能工作的模型,然后基于数据驱动的分析迭代改进。这种方式比凭直觉设计更高效。

为什么快速迭代有效? 因为你不可能预先知道哪里是瓶颈。可能你以为数据不够,但实际上是模型架构有问题;可能你以为需要更复杂的特征工程,但实际上简单模型就够了。只有实现并测试,才能获得真实反馈。

在下一节,我们将继续讨论更多策略:如何处理标注错误的数据、如何应对训练集和测试集分布不一致、何时使用迁移学习和多任务学习、端到端学习的利弊。这些都是实际项目中常遇到的问题,掌握这些策略能让你的开发效率提升数倍。