OCR与人工数据

我们已经走过了漫长的机器学习学习之旅。从线性回归到神经网络,从聚类到推荐系统,从理论到实践,我们掌握了丰富的算法和技术。但在课程的最后,让我们通过一个完整的应用案例,把所有这些知识串联起来,看看如何构建一个真实的机器学习系统。

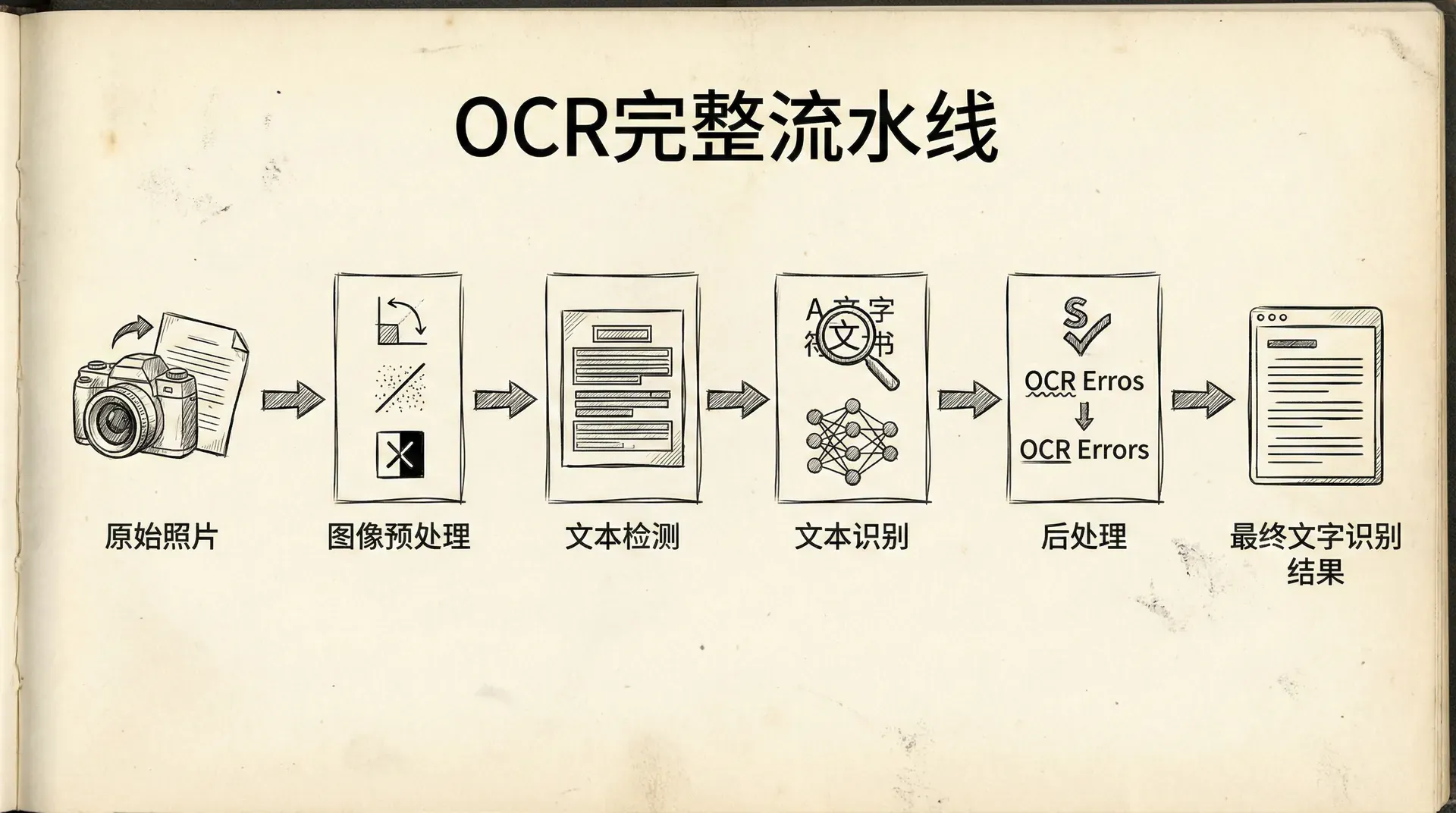

这最后的一节课中我们将聚焦光学字符识别(OCR)系统——把图像中的文字转换成可编辑的文本。OCR不仅是一个经典的计算机视觉问题,更是一个展示机器学习完整流水线的绝佳案例。 我们会学习如何分解复杂问题、如何构建处理流水线、如何获取和生成训练数据。这些技能对于将机器学习应用到任何实际问题都至关重要。

问题描述:照片中的文字识别

假设我们要开发一个移动应用,用户用手机拍摄街景照片,应用能够识别照片中的文字——比如商店招牌、路牌、海报上的文字。这个任务的挑战在于:

- 照片中可能有多处文字,位置和大小各异

- 背景复杂,可能有建筑、人、车辆等干扰

- 光照条件、拍摄角度千变万化

- 文字可能有不同的字体、颜色、样式

如何处理这样一个复杂的问题?

面对复杂的机器学习问题,关键是分解(decompose)。把大问题分解成几个小问题,每个小问题相对容易解决。然后把这些解决方案组合成一个流水线(pipeline)。

OCR流水线

我们可以把OCR任务分解成几个阶段:

阶段1:文字检测(Text Detection)

- 在图像中找到包含文字的区域

- 输入:整张图像

- 输出:多个文字区域的边界框

阶段2:字符分割(Character Segmentation)

- 把文字区域分割成单个字符

- 输入:一个文字区域

- 输出:单个字符的位置

阶段3:字符识别(Character Recognition)

- 识别每个字符是什么

- 输入:单个字符图像

- 输出:字符类别(A-Z, 0-9等)

每个阶段都是一个机器学习问题,我们可以独立地训练模型,然后把它们组合起来。

流水线的优势:

- 模块化:每个阶段可以独立开发和改进

- 可调试:可以分别评估每个阶段的性能,找出瓶颈

- 可复用:某些模块(如字符识别)可以用在其他应用中

- 团队协作:不同的人可以并行工作在不同阶段

滑动窗口技术

文字检测的一个经典方法是滑动窗口(Sliding Window)。

基本思想:

用一个固定大小的窗口在图像上滑动,对每个位置判断是否包含文字。

步骤:

- 选择窗口大小(比如80x40像素)

- 从图像左上角开始,每次移动几个像素(比如步长为4像素)

- 对每个窗口位置,提取图像patch

- 用分类器判断这个patch是否包含文字

- 如果是,记录这个位置

- 用不同的窗口大小重复(处理不同尺度的文字)

|def slidingWindow(image, classifier, window_sizes, step_size=4): """ 滑动窗口检测 image: 输入图像 classifier: 训练好的分类器 window_sizes: 窗口尺寸列表 [(w1, h1), (w2, h2), ...] step_size: 滑动步长 """ detections = [] for (win_w, win_h) in window_sizes: # 滑动窗口 for y in range(0, image.shape[0] - win_h, step_size): for x in range(0

滑动窗口方法在计算机视觉中有着非常广泛的实际应用。例如,人脸检测任务往往需要在整张图片的不同位置和尺度寻找可能的人脸区域,通过滑动窗口可以系统性地遍历图像每一个子区域,从而发现人脸的存在。同理,在行人检测问题中,滑动窗口算法可以用于识别并定位图片或视频帧中所有出现的行人。 对于通用的物体检测,滑动窗口能够辅助发现任何类型的物体,而不仅限于特定类别。此外,文字检测任务也高度依赖滑动窗口方法,以便找到图像中存在的字符或文本区域。

在实际应用滑动窗口方法时,有几种常见的高效优化手段。首先,可以采用图像金字塔技术:通过缩放原始输入图像生成一系列不同分辨率的图像,而不只是简单地改变滑动窗口的大小。 这样既能检测不同尺寸的目标,又能降低计算代价。其次,结合级联分类器架构,在预处理阶段先用简单、计算速度很快的弱分类器初步筛除显然不属于目标的区域,然后再使用更复杂、效果更精细的强分类器进一步精确判断,这样能够显著减少整体计算量。 最后,针对某些明显不可能包含目标的区域,比如图像中的纯色大块或完全纹理一致的区域,可以直接跳过它们的窗口扫描与特征提取,从而节省计算资源并加快检测速度。

获取训练数据

训练一个好的机器学习模型需要大量数据。但获取标注数据往往很昂贵:

- 人工标注耗时耗力

- 需要专业知识(比如医学图像需要医生标注)

- 难以获得罕见情况的样本

有两个策略可以帮助我们:

- 人工数据合成(Artificial Data Synthesis)

- 数据增强(Data Augmentation)

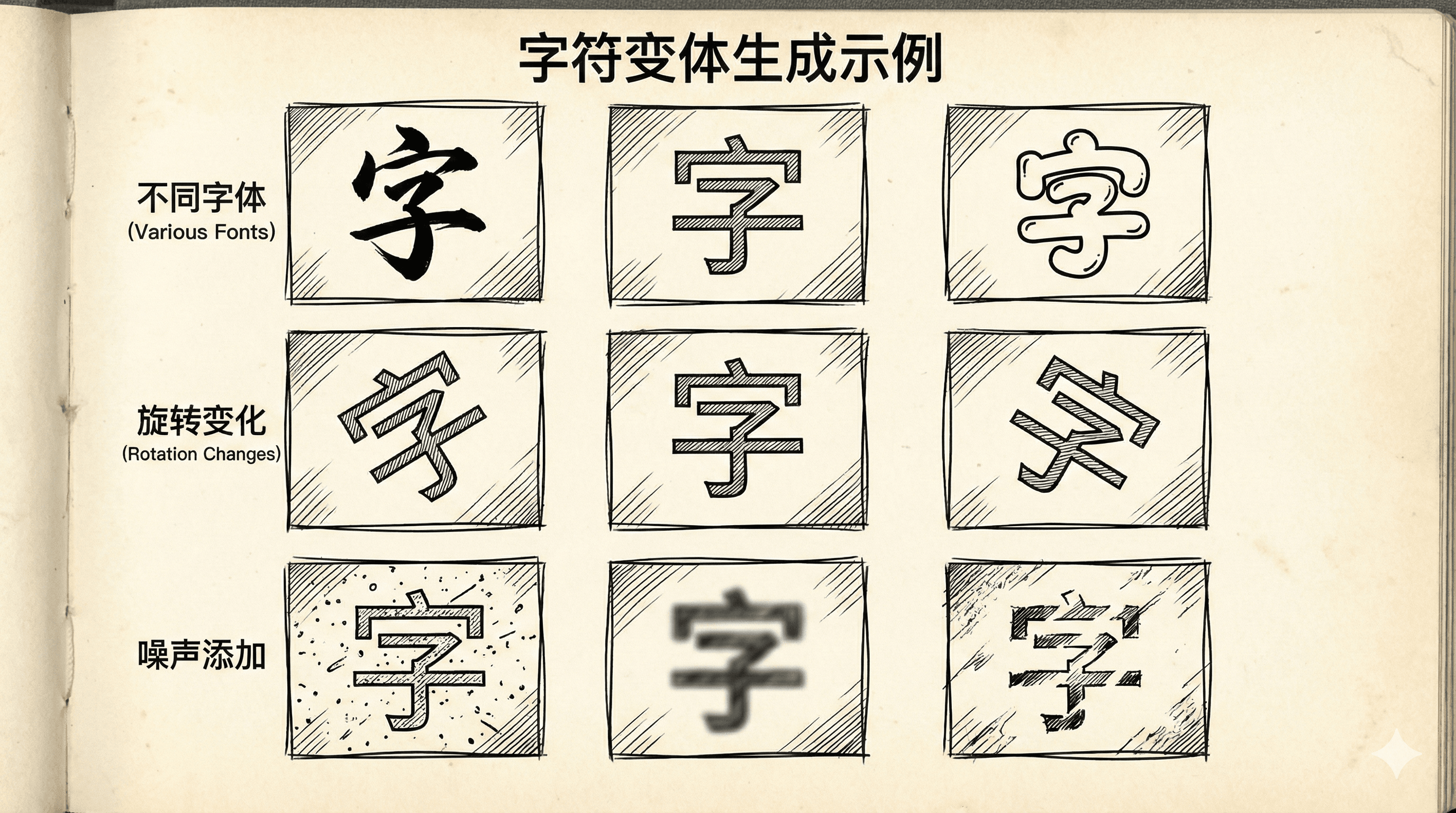

人工数据合成

对于OCR,我们可以用计算机生成大量训练数据:

方法1:从字体库生成

|from PIL import Image, ImageDraw, ImageFont import numpy as np def generateCharacterImage(char, font_path, size=32): """ 生成单个字符的图像 """ # 创建空白图像 img = Image.new('L', (size, size), color=255) draw = ImageDraw.Draw(img) # 加载字体 font = ImageFont.truetype(font_path, size=

通过人工合成,我们可以:

- 生成无限量的数据

- 控制数据的分布(字体、大小、旋转等)

- 确保标注100%正确

- 快速迭代和实验

方法2:从现实数据加噪声

如果我们有一些真实的文字图像,可以通过添加各种变换和噪声来扩充:

|def augmentRealImages(image, num_augmented=10): """ 从一张真实图像生成多个变体 """ augmented = [] for _ in range(num_augmented): img_aug = image.copy() # 随机亮度 brightness = np.random.uniform(0.7, 1.3) img_aug = np.clip(img_aug * brightness, 0, 255

数据增强的其他应用

数据增强不仅用于OCR,在很多领域都很有效:

图像分类:

- 翻转、旋转、裁剪

- 颜色抖动、亮度调整

- 随机擦除部分区域

语音识别:

- 添加背景噪音(咖啡厅、街道、办公室)

- 改变音高和速度

- 混响和回声

自然语言处理:

- 同义词替换

- 随机插入、删除词汇

- 回译(翻译成另一种语言再翻译回来)

在投入资源获取更多真实数据前,先尝试数据增强和人工合成。很多时候,聪明地使用现有数据比获取新数据更高效。但要确保合成数据与真实数据的分布接近,否则模型在真实场景中可能表现不佳。

构建完整的OCR系统

让我们把所有部分组合起来:

|class OCRSystem: def __init__(self): self.text_detector = loadModel('text_detector.pkl') self.char_segmenter = loadModel('char_segmenter.pkl') self.char_recognizer = loadModel('char_recognizer.pkl') def recognizeText(self, image): """ 识别图像中的所有文字 """ results = [] # 步骤1:检测文字区域

性能优化与调试

构建一个工作的系统只是第一步。如何让它更准确、更快?

天花板分析(Ceiling Analysis)

系统由多个模块组成,哪个模块是瓶颈?天花板分析能帮助我们找到最值得改进的部分。

方法:

- 测量整个系统的性能(比如准确率90%)

- 假设第一个模块是完美的(100%准确),测量系统性能

- 假设前两个模块都完美,测量系统性能

- 依此类推

这样可以看出改进每个模块能带来多大提升。

这个分析告诉我们:改进文字检测只能提升1%,但改进字符分割或识别能各提升4%。所以应该优先改进后两者。

开发机器学习系统时,建议首先实现一个最简可运行的版本,确保端到端流程畅通。在此基础上,量化各模块的性能,通过天花板分析和误差分析定位系统瓶颈,将主要精力集中于最影响整体表现的环节进行优化。 同时,要在真实业务数据和多样场景下持续系统性地评估整体效果,避免陷入对非核心环节的过早优化或仅关注训练集表现。

课程总结

恭喜你完成了整个机器学习课程!在这段旅程中,你应该已经掌握了监督学习(如线性回归、逻辑回归、神经网络、支持向量机)、无监督学习(如K-Means聚类、PCA降维、异常检测)、推荐系统、大规模机器学习等核心知识,也学会了模型评估、诊断、超参数选择和误差分析等实践技能。

更重要的是,你已经建立了以数据驱动决策、系统性问题分析、持续迭代优化和权衡偏差与方差的思维方法。 机器学习是一个快速发展的领域。这门课程教授的是基础和原理——这些原理经受住了时间的考验,也是理解最新技术的基础。无论是深度学习的最新架构,还是强化学习的新算法,核心思想都与我们学的内容一脉相承。

记住Andrew Ng的话:“AI is the new electricity”。

机器学习正在改变世界的方方面面。你现在拥有了这个强大工具的钥匙。去探索,去创造,去解决真实世界的问题。机器学习的旅程才刚刚开始!