微服务架构中的 API 网关

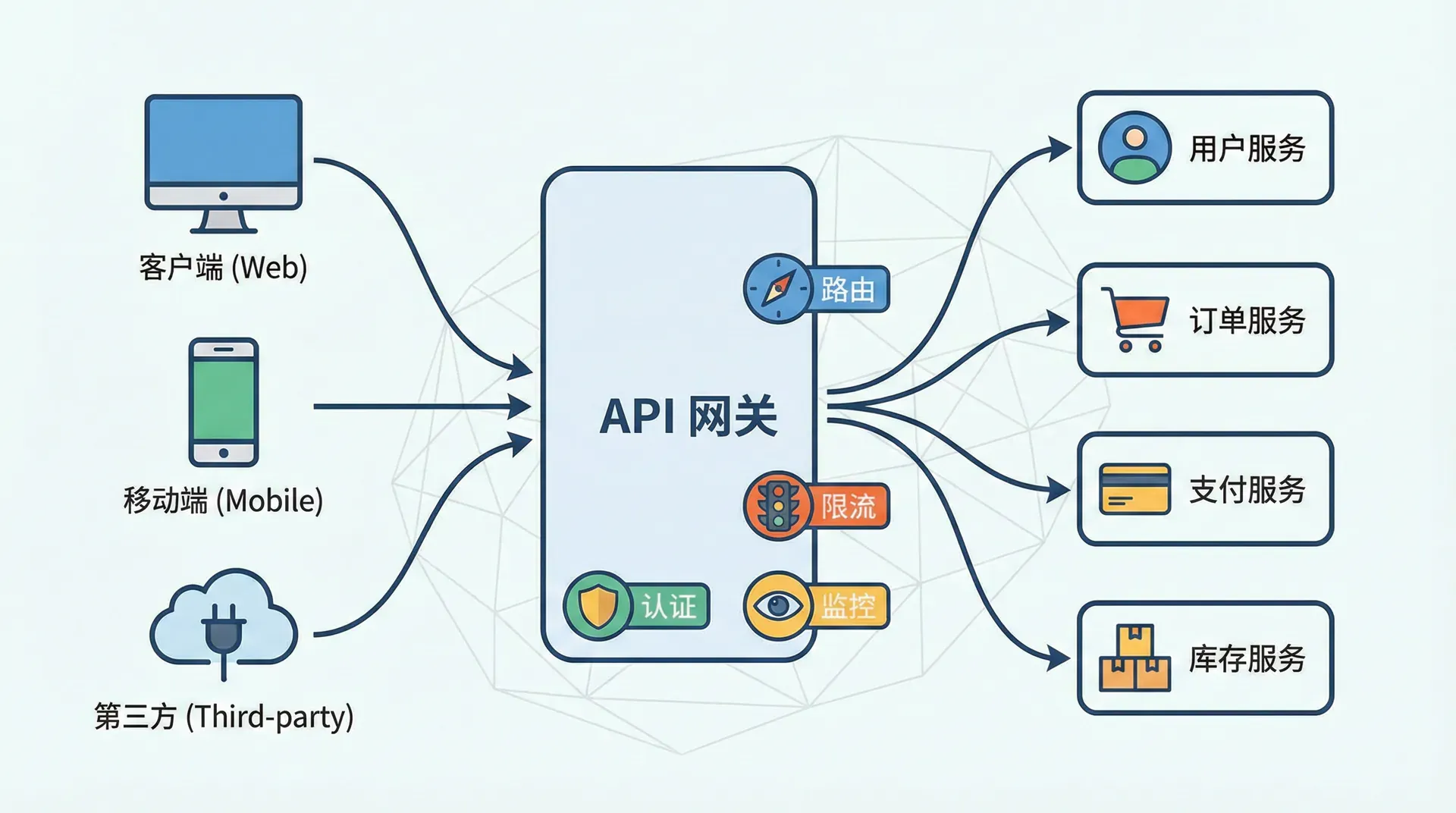

在微服务架构的世界里,一个完整的应用系统被拆分成众多独立部署和运行的小型服务。这种架构带来了灵活性和可扩展性,但也引入了新的复杂性:客户端如何与这些分散的服务进行交互?如何统一处理认证、限流、监控等横切关注点?API 网关正是为解决这些问题而生的核心基础设施组件。

API 网关作为所有 API 请求的统一入口,扮演着流量管理者、安全守卫和协议翻译官的多重角色。 这节课我们将深入探讨 API 网关在微服务架构中的定位、核心功能、实现模式,以及主流网关解决方案的对比与选型策略。

API 网关的角色与价值

为什么需要 API 网关

在单体应用时代,客户端只需要与一个后端服务交互,事情相对简单。但当应用被拆分成微服务后,情况变得复杂起来。一个页面的渲染可能需要从多个服务获取数据,客户端需要知道每个服务的地址,分别发起请求,这不仅增加了客户端的复杂性,还带来了一系列问题。

- 首先是服务发现的问题。微服务通常运行在动态的容器环境中,服务实例的地址可能随时变化。让每个客户端都具备服务发现能力是不现实的,特别是对于浏览器和移动应用这类受限的客户端环境。

- 其次是横切关注点的重复实现。认证授权、限流、日志记录、指标收集等功能在每个服务中都需要,如果每个服务独立实现,不仅浪费开发资源,还难以保证一致性。

- 第三是协议适配的需求。内部服务可能使用 gRPC 等高效的二进制协议进行通信,但面向外部客户端时,通常需要提供 REST/JSON 接口。这种协议转换如果由每个服务自行处理,会增加服务的复杂度。

API 网关通过在客户端和后端服务之间引入一个中间层,优雅地解决了这些问题。客户端只需要与网关交互,由网关负责路由请求到正确的服务,处理各种横切关注点,并在必要时进行协议转换。

网关的核心职责

API 网关承担着多重职责,可以将其归纳为几个主要类别。

请求路由是网关最基本的职责。网关根据请求的路径、头部、参数等信息,将请求转发到对应的后端服务。这种路由可以是简单的路径前缀匹配,也可以是基于复杂规则的智能路由。

流量管理包括负载均衡、限流、熔断、重试等功能。网关可以将请求均匀分发到服务的多个实例,在服务过载时拒绝部分请求保护系统,在服务故障时快速失败避免级联故障,以及在临时错误时自动重试。

安全控制是网关的另一核心职责。网关可以统一处理身份认证,验证 API 密钥或 JWT 令牌的有效性,检查用户是否有权限访问特定资源,过滤恶意请求,以及实施 WAF(Web 应用防火墙)规则。

可观测性功能使运维团队能够了解系统的运行状况。网关可以记录所有请求的日志,收集响应时间、错误率等指标,实施分布式追踪,帮助快速定位问题。

协议转换和请求聚合则为客户端提供便利。网关可以将 REST 请求转换为内部的 gRPC 调用,或者将多个服务的响应聚合成一个统一的响应返回给客户端,减少客户端需要发起的请求次数。

请求路由机制

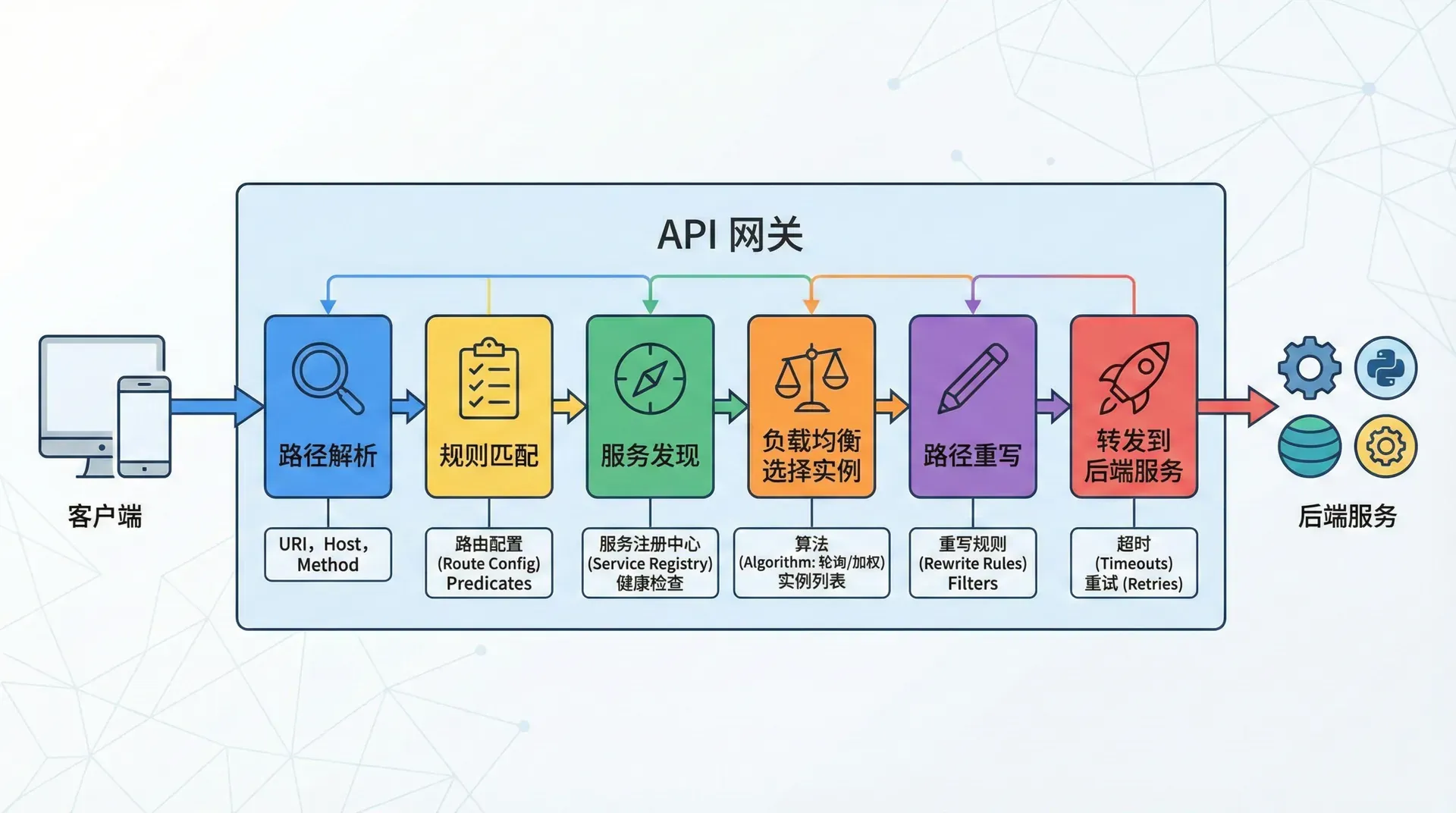

路由是 API 网关最基础也最重要的功能,它决定了每个请求应该被转发到哪个后端服务。一个设计良好的路由系统应该既灵活又高效,能够适应各种复杂的业务场景。

路由匹配规则

最简单的路由规则是基于路径前缀的匹配。例如,所有以 /users 开头的请求路由到用户服务,以 /orders 开头的请求路由到订单服务。这种规则简单直观,适合服务边界清晰的场景。

更复杂的路由可能需要考虑多个因素。路径模式匹配支持通配符和正则表达式,如 /api/v*/users/* 匹配任意版本的用户相关请求。HTTP 方法匹配允许同一路径的不同方法路由到不同服务,这在实现读写分离时很有用。头部匹配可以根据请求头的值来路由,常用于 A/B 测试或金丝雀发布场景。

查询参数和请求体内容也可以作为路由依据,虽然这种方式不太常见。例如,根据请求中的租户 ID 将请求路由到特定的服务实例,实现多租户隔离。

路由规则的优先级管理是一个需要注意的问题。当多个规则都能匹配同一个请求时,需要有明确的优先级规则来确定使用哪个路由。通常,更具体的规则(如精确路径匹配)优先于更通用的规则(如路径前缀匹配)。

动态路由与服务发现

在微服务环境中,服务实例的地址不是静态的,服务可能随时启动新实例或关闭旧实例,IP 地址也可能变化。网关需要与服务发现系统集成,动态获取服务实例的当前地址。

常见的服务发现系统包括 Consul、Eureka、Nacos、Kubernetes 服务等。网关定期从这些系统查询服务实例列表,或者订阅服务变更事件实时更新路由表。这种动态路由能力使网关能够适应服务实例的弹性伸缩,无需人工干预。

健康检查是与服务发现密切相关的功能。网关可以主动对后端服务进行健康检查,及时发现不健康的实例并将其从路由目标中移除,避免将请求发送到无法正常服务的实例。健康检查可以是简单的 TCP 连接测试,也可以是更复杂的 HTTP 端点调用,验证服务的业务逻辑是否正常工作。

路径重写

在许多场景下,客户端请求的路径与后端服务期望的路径并不一致,网关需要在转发请求时进行路径重写。

最常见的情况是剥离路径前缀。例如,客户端请求 /api/users/123,网关将请求路由到用户服务,但用户服务期望的路径是 /users/123,网关需要在转发时去掉 /api 前缀。

更复杂的重写可能涉及路径的转换。例如,将 /v2/users/123 重写为 /users/123?version=2,实现版本号从路径到查询参数的转换。正则表达式替换提供了强大的重写能力,但也增加了配置的复杂性和出错的可能性。

响应路径也可能需要重写。当服务响应中包含指向自身的 URL(如分页链接、资源位置等)时,这些 URL 可能需要调整以反映网关暴露的路径结构,而不是服务内部的路径。

负载均衡策略

当一个服务运行多个实例时,网关需要决定将每个请求发送到哪个实例。负载均衡策略影响着请求的分布、系统的整体性能和可用性。

常见负载均衡算法

轮询是最简单的负载均衡算法,请求按顺序依次分配给各个实例。这种算法实现简单,在所有实例性能相近时能够实现均匀分布。但如果实例的处理能力不同,轮询可能导致某些实例过载而另一些实例空闲。

加权轮询为每个实例分配一个权重,权重高的实例分配到更多的请求。这可以用于处理实例性能不均的情况,为配置更好的实例分配更多流量。权重可以静态配置,也可以根据实例的实时表现动态调整。

最少连接算法将请求发送到当前活跃连接数最少的实例。这种算法能够更好地适应请求处理时间不均的情况,处理快的实例自然会承担更多请求。加权最少连接结合了权重和连接数两个因素,适用于实例性能差异较大的场景。

随机算法随机选择一个实例来处理请求。虽然看起来不够"智能",但在实例数量较多时,随机分布的效果与轮询相近,而且实现更简单,不需要维护状态。

一致性哈希根据请求的某个属性(如用户 ID、会话 ID)计算哈希值,将相同哈希值的请求始终路由到同一实例。这种策略在需要会话亲和性或利用本地缓存的场景中非常有用,但可能导致负载分布不够均匀。

健康检查与故障转移

有效的负载均衡离不开健康检查机制。网关需要知道哪些实例是健康的,以避免将请求发送到无法正常服务的实例。

主动健康检查由网关定期向每个实例发送探测请求,根据响应判断实例的健康状态。探测可以是简单的 TCP 连接,也可以是对特定健康检查端点的 HTTP 请求。主动检查的优点是能够快速发现问题,但会产生额外的网络流量和服务端负载。

被动健康检查基于实际的业务请求来评估实例健康状态。如果某个实例连续多次返回错误或超时,网关将其标记为不健康并暂时移出负载均衡池。这种方式不产生额外的探测流量,但发现问题的速度可能不如主动检查及时。

许多网关系统同时使用主动和被动两种健康检查,结合两者的优点。不健康的实例在经过一段时间后会被重新纳入健康检查,如果恢复正常则重新加入负载均衡池。

故障转移策略决定了当请求失败时如何处理。简单的策略是立即将错误返回给客户端;更智能的策略是自动重试其他实例,如果在配置的重试次数内成功则对客户端透明地返回成功响应。重试需要谨慎配置,确保只对幂等操作启用,避免对非幂等操作的重复执行。

认证与授权

安全是 API 网关的核心职责之一。在网关层统一处理认证和授权,可以避免每个后端服务重复实现安全逻辑,确保安全策略的一致执行,同时简化后端服务的开发。

认证机制

API 密钥是最简单的认证方式。客户端在请求中携带一个预先分配的密钥(通常在请求头或查询参数中),网关验证密钥的有效性。这种方式实现简单,适合服务对服务的通信或简单的第三方集成,但密钥的管理和轮换可能带来挑战。

OAuth 2.0 是更复杂但也更灵活的认证框架。在典型的流程中,客户端首先从授权服务器获取访问令牌,然后在 API 请求中携带这个令牌。网关可以验证令牌的有效性,提取其中的用户身份和权限信息,或者将验证工作委托给授权服务器。OAuth 2.0 支持多种授权流程,适用于不同的客户端类型和安全需求。

JWT(JSON Web Token)是一种自包含的令牌格式,常与 OAuth 2.0 配合使用。JWT 令牌中包含了用户身份、权限、过期时间等信息,并通过数字签名保证完整性。网关可以在本地验证 JWT 的签名和有效性,无需每次都调用授权服务器,这大大提高了验证效率。但 JWT 的一个挑战是令牌撤销:一旦签发的 JWT 无法在过期前撤销,除非维护一个撤销列表或使用较短的过期时间。

mTLS(双向 TLS)提供了基于证书的强认证。客户端和服务器都需要提供证书并相互验证,这在服务网格环境和对安全性要求极高的场景中常见。mTLS 可以作为其他认证机制的补充或替代,提供传输层的身份验证。

授权策略

认证确认了"你是谁",授权则决定"你能做什么"。网关可以基于认证过程中获得的身份信息,执行各种授权策略。

基于角色的访问控制(RBAC)是最常见的授权模型。用户被分配一个或多个角色,每个角色关联一组权限。网关检查用户的角色是否包含访问当前资源所需的权限。例如,只有"管理员"角色可以访问 /admin/* 路径下的端点。

基于属性的访问控制(ABAC)提供了更细粒度的控制。授权决策基于主体(用户)、资源、操作和环境等多个属性的组合。例如,用户只能访问自己创建的资源,或者只能在工作时间内执行某些操作。ABAC 更加灵活,但也更复杂。

范围(Scopes)是 OAuth 2.0 中的授权概念,定义了访问令牌的权限边界。客户端请求特定的范围,用户授权同意后,签发的令牌只包含这些范围。网关检查请求所需的范围是否在令牌中。这种机制特别适合第三方应用的授权,用户可以选择授予应用有限的访问权限。

在网关层实现的授权通常是粗粒度的,例如检查用户是否有权访问某个 API 端点。更细粒度的业务授权(如用户是否有权访问特定的数据记录)通常需要在后端服务中实现,因为这些决策依赖于业务逻辑和数据访问层的信息。网关和服务之间应该有清晰的责任边界。

限流与熔断

保护系统免受过载是 API 网关的重要职责。通过限流和熔断机制,网关可以在高负载情况下保持系统的稳定性,防止服务雪崩。

限流实现

网关层的限流可以从多个维度实施。全局限流控制整个系统的请求总量,防止系统整体过载。每客户端限流为每个客户端(通过 API 密钥或用户 ID 识别)分配独立的配额,确保公平使用,防止单个客户端影响其他用户。每服务限流控制到达特定后端服务的请求量,保护该服务不被压垮。

令牌桶算法是常用的限流实现。每个限流维度维护一个令牌桶,令牌以固定速率添加到桶中,每个请求消耗一个令牌。如果桶中没有足够的令牌,请求被拒绝或排队等待。令牌桶允许一定程度的突发流量(消耗积累的令牌),同时控制长期的平均速率。

在分布式环境中,限流状态需要在多个网关实例间共享。常见的做法是使用 Redis 等分布式存储来维护计数器和令牌桶状态。这确保了无论请求到达哪个网关实例,限流规则都能正确执行。

限流响应应该提供有用的信息。被限流的请求返回 429 Too Many Requests 状态码,响应头中包含限流信息(如 Retry-After、X-RateLimit-Remaining 等),帮助客户端理解限流规则并适当调整行为。

熔断器模式

熔断器模式源自电路保护的概念:当检测到故障时,快速断开电路,防止问题扩散。在 API 网关中,熔断器监控对后端服务的调用,当故障率超过阈值时,熔断器"打开",后续请求直接失败返回,不再尝试调用后端服务。

熔断器通常有三个状态。关闭状态是正常工作状态,请求正常转发到后端服务。打开状态是熔断激活状态,所有请求直接失败,不调用后端。半开状态是恢复探测状态,允许少量请求通过以测试后端是否恢复,如果成功则关闭熔断器,否则继续保持打开。

熔断阈值的设置需要权衡。阈值太低可能导致正常的偶发错误触发熔断;阈值太高则可能让故障持续时间过长才被熔断。常见的配置包括在指定时间窗口内的错误数量或错误率,以及连续失败的次数。

熔断器打开时,网关可以选择不同的失败策略。立即返回错误是最简单的方式;返回缓存的响应可以为某些读取操作提供降级服务;重定向到备用服务可以保持部分功能可用。策略的选择取决于业务需求和可用的备选方案。

降级策略

当后端服务不可用或响应缓慢时,除了熔断之外,还可以实施各种降级策略来维持系统的部分功能。

静态响应降级返回预先配置的静态内容,替代无法获取的动态数据。例如,当推荐服务不可用时,返回一个默认的推荐列表。这种降级虽然数据不够精准,但总比完全失败的用户体验要好。

功能降级关闭某些非核心功能,保证核心流程可用。例如,在系统高负载时暂时关闭搜索建议功能,将资源集中于基本的搜索和浏览功能。

超时控制是另一种形式的降级。为后端调用设置合理的超时时间,避免慢响应占用过多资源。超时后可以返回错误或尝试降级响应,防止请求长时间挂起影响用户体验和系统资源。

协议转换与请求聚合

API 网关不仅是一个简单的请求转发器,还可以在请求和响应的处理过程中进行复杂的转换,为客户端提供更便利的接口。

协议转换

内部微服务之间可能使用高效的二进制协议(如 gRPC、Thrift)进行通信,但对外暴露的 API 通常需要是更通用的 REST/JSON 格式。API 网关可以承担协议转换的职责,对外提供 REST 接口,在内部与 gRPC 服务通信。

gRPC 到 REST 的转换是一个常见场景。网关接收 REST 请求,解析请求内容,构造 gRPC 调用,然后将 gRPC 响应转换回 JSON 格式返回给客户端。这种转换可以基于预定义的映射规则自动完成,gRPC 的 HTTP 转码功能提供了标准化的方式来定义这种映射。

WebSocket 和服务端推送是另一类协议转换场景。客户端可能通过 WebSocket 与网关建立长连接,网关将消息转换为对后端服务的 HTTP 请求,或者与后端的消息系统集成,实现实时双向通信。

数据格式的转换也属于此类功能。网关可以将后端服务返回的 XML 数据转换为客户端偏好的 JSON 格式,或者根据内容协商头部选择合适的格式。这使得后端服务可以专注于业务逻辑,不必关心各种客户端的格式偏好。

请求聚合

在微服务架构中,一个页面的数据可能来自多个服务。如果由客户端分别调用这些服务,会增加请求次数和整体延迟。网关可以提供请求聚合功能,将一个客户端请求分解为对多个服务的并行调用,然后将结果合并后返回。

后端为前端模式(Backend for Frontend,BFF)是一种常见的聚合模式。针对每种客户端类型(Web、移动、IoT 等),创建一个专门的 API 层,这个 API 层了解该类型客户端的特定需求,从多个后端服务获取数据并组装成适合该客户端的响应格式。BFF 可以实现为网关的一部分,也可以是独立的服务。

GraphQL 网关是另一种聚合方式。GraphQL 的模式定义跨越多个后端服务,当客户端发起查询时,网关根据查询内容确定需要调用哪些服务,并行执行调用,最后将结果按照查询的结构组装返回。这种方式给予客户端极大的灵活性来指定需要的数据。

聚合逻辑需要处理部分失败的情况。当聚合请求涉及多个后端服务调用,如果某个调用失败,应该如何处理?返回部分数据还是完全失败?是否可以使用降级数据?这些决策需要根据业务需求来定义。

可观测性

在分布式系统中,可观测性至关重要。API 网关处于所有外部请求的必经之路,是实施监控、日志和追踪的理想位置。

日志记录

网关应该记录所有请求的详细信息,这些日志对于问题排查、安全审计和使用分析都非常有价值。典型的访问日志包括:请求时间戳、客户端 IP、用户身份、请求方法和路径、查询参数、请求头部、响应状态码、响应时间、响应大小等。

日志的格式应该结构化,便于后续的分析和查询。JSON 格式的日志越来越流行,因为它易于被日志分析工具解析和索引。日志中应该包含关联 ID(如请求 ID),使得可以追踪一个请求在整个系统中的处理过程。

日志的级别和详细程度需要权衡。记录太少可能在排查问题时缺乏关键信息;记录太多则会产生大量数据,增加存储成本和分析难度。一种常见的做法是默认记录摘要信息,在需要时可以动态提高特定请求或客户端的日志详细程度。

敏感信息的处理需要特别注意。请求和响应中可能包含密码、令牌、个人身份信息等敏感数据,这些内容在记录日志前应该被脱敏或完全排除。良好的日志实践需要在可观测性和隐私保护之间取得平衡。

指标收集

指标提供了系统行为的量化视图,是监控和告警的基础。网关应该收集多维度的指标数据。

请求量指标包括总请求数、按路径/方法/状态码分组的请求数、按客户端分组的请求数等。这些指标帮助了解系统的使用模式和负载分布。

延迟指标记录请求的响应时间,通常包括平均值、中位数、95/99 百分位数等多个统计量。百分位数比平均值更能反映用户的实际体验,因为少数极慢的请求会被平均值掩盖,但在百分位数中会显现出来。

错误率指标统计各类错误的发生频率,是服务健康度的重要指标。区分客户端错误(4xx)和服务端错误(5xx)很重要,两者的根因和处理方式不同。

资源使用指标包括网关本身的 CPU、内存、网络带宽使用情况,以及连接池、线程池等资源的使用状态。这些指标帮助容量规划和性能优化。

Prometheus 是云原生环境中广泛使用的指标收集系统,大多数 API 网关都支持导出 Prometheus 格式的指标。配合 Grafana 等可视化工具,可以构建直观的监控仪表盘。

分布式追踪

在微服务架构中,一个请求可能经过多个服务的处理。分布式追踪技术将这些分散的处理过程关联起来,形成完整的调用链视图,对于理解系统行为和排查性能问题非常有价值。

网关作为请求的入口,是注入追踪上下文的理想位置。当请求到达网关时,如果请求中没有追踪信息,网关生成一个新的追踪 ID;如果请求中已有追踪信息(来自上游系统),网关继续使用它。网关在转发请求时,将追踪 ID 通过请求头传递给后端服务,后端服务继续传播这个 ID,形成完整的追踪链。

常见的分布式追踪标准包括 OpenTracing、OpenTelemetry 和 W3C Trace Context。选择一个标准并在整个系统中一致使用,确保追踪信息能够正确传播和收集。追踪数据可以发送到 Jaeger、Zipkin、Datadog 等追踪系统进行存储和分析。

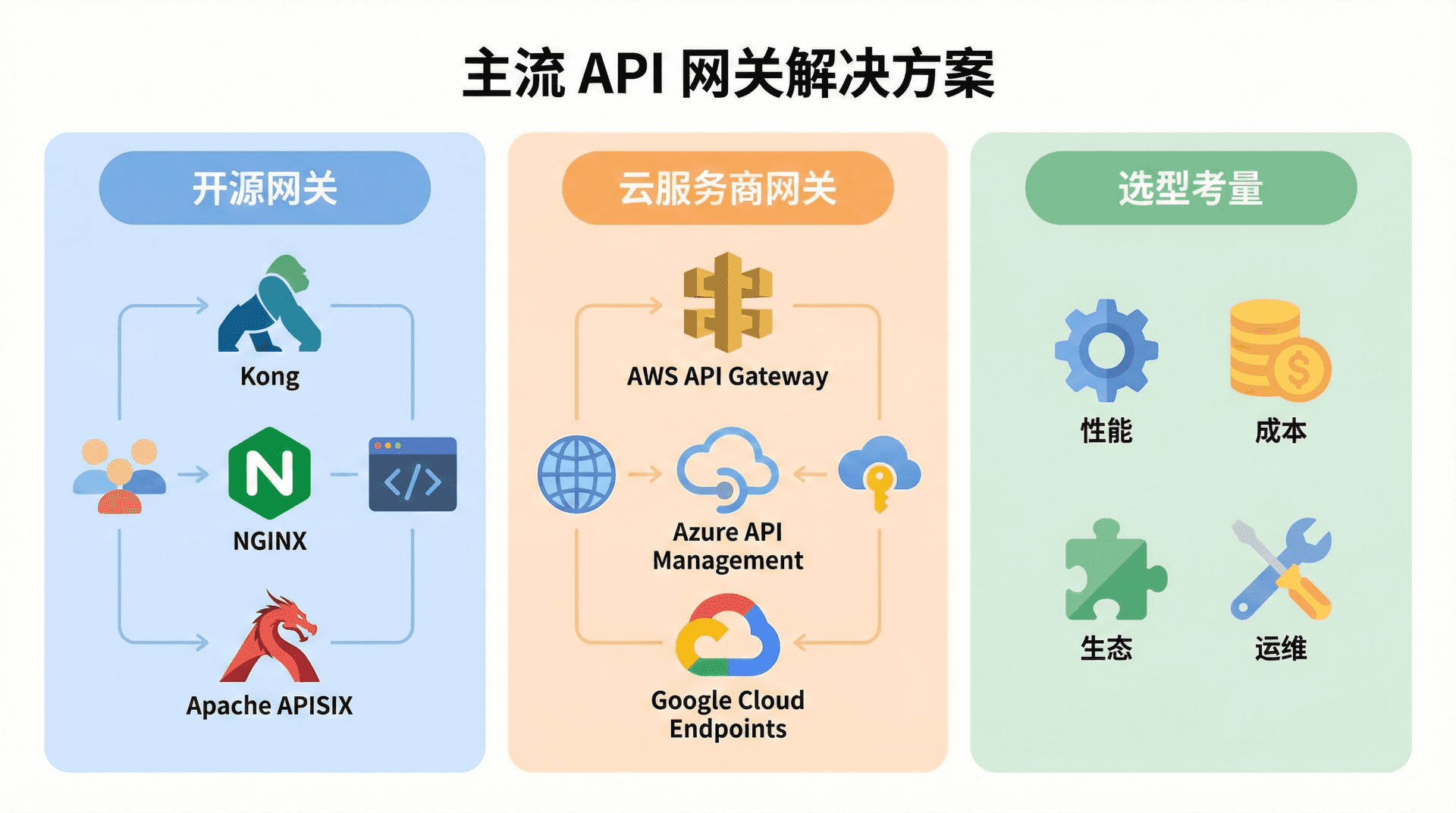

主流 API 网关解决方案

市场上有众多 API 网关产品,从开源项目到商业解决方案,各有特点。了解主流选项的特性有助于根据需求做出合适的选择。

开源网关

Kong 是基于 Nginx 和 OpenResty 构建的高性能开源网关。它具有丰富的插件生态,涵盖认证、限流、日志、转换等各种功能。Kong 可以通过 RESTful API 或声明式配置进行管理,支持在 Kubernetes 环境中以 Ingress Controller 方式运行。Kong 的企业版提供了额外的功能和支持。

APISIX 是 Apache 基金会的开源项目,同样基于 Nginx 和 Lua,但在架构上有所创新。它使用 etcd 作为配置中心,支持热更新路由规则而无需重启。APISIX 声称提供比 Kong 更好的性能,并且完全开源,没有功能上的开源/商业版区分。

Envoy 是由 Lyft 开源的高性能代理,作为 Istio 服务网格的数据平面而广为人知。Envoy 虽然主要定位于服务间通信,但也可以用作 API 网关。它提供了丰富的负载均衡、熔断、追踪等功能,并且性能优异。Envoy 的配置相对复杂,通常与控制平面(如 Istio)配合使用。

Spring Cloud Gateway 是 Spring 生态中的网关解决方案,基于 Spring WebFlux 构建,适合 Java 技术栈的团队。它与 Spring 生态的其他组件(如 Eureka、Config Server)集成良好,使用 Java 代码或 YAML 配置路由规则,对于 Java 开发者来说学习曲线较低。

云服务商网关

主流云服务商都提供托管的 API 网关服务,降低了运维负担。

AWS API Gateway 是亚马逊云的 API 管理服务,与 Lambda、IAM 等 AWS 服务深度集成。它支持 REST 和 WebSocket API,提供请求验证、速率限制、缓存等功能。对于已在 AWS 生态中的团队,这是一个便捷的选择。

Azure API Management 是微软云的 API 管理平台,除了网关功能外还提供开发者门户、API 版本管理、分析等功能。它适合企业级的 API 管理需求。

Google Cloud Apigee 是谷歌云的 API 管理平台,源自 Apigee 这个老牌的 API 管理厂商。它功能全面,特别在 API 分析和货币化方面有深厚积累,适合需要将 API 作为产品对外提供的企业。

阿里云 API 网关是面向中国市场的主流选择,与阿里云的函数计算、容器服务等产品集成良好,提供中国区域的优化和合规支持。

选型考量

选择 API 网关不必追求功能最强大的方案,而应该选择最适合当前需求和团队能力的方案。一个简单的方案如果能够满足需求,往往比复杂的方案更易于维护和演进。随着业务发展,网关也可以逐步升级或替换,关键是在设计时保持良好的抽象,降低未来迁移的成本。

小结

本节内容围绕 API 网关在微服务架构中的核心地位和关键功能展开,用通俗的方式带大家了解了它如何统一处理流量、保障安全、简化后端开发,并帮助我们提升系统的可观测性和运维效率。 对于每个用户而言,无论是网关的请求路由、负载均衡,还是认证、限流、协议转换等能力,其背后都关系到系统的稳定与体验。

面对市面上丰富的网关解决方案,没有一种产品能适合所有团队和场景。结合自身的技术栈、业务复杂度以及团队资源,理性权衡开源与云服务的优势,选出最贴合当前需求的方案才是最佳路径。 接下来我们将进入 RESTful 服务的测试与安全专题,继续为 API 的高质量与高安全性保驾护航。